Java 后端开发2025年面经与项目面试技巧(DeepSeek总结版)

目录指引:

自我介绍

核心原则

- 结构化清晰:遵循“总 - 分 - 总”的逻辑,让面试官轻松跟上你的思路。

- 价值导向:不说“我做了XX”,而是说“我通过XX技术,解决了XX问题,带来了XX价值”。

- 与岗位匹配:提前研究JD,将你的技能和经验与公司的技术要求、业务方向对齐。

- 自信沉稳:语速平稳,眼神交流,展现专业与诚意。

自我介绍框架(黄金1.5-2分钟)

第一部分:开场白 & 基本信息 (15秒)

目的:礼貌开场,清晰说明你的身份和工作经验。

话术:

“各位面试官,下午好。我叫[你的名字],非常感谢给我这次面试机会。我拥有3年的Java后端开发经验,上一家公司是在[上一家公司名称],主要负责[你负责的核心领域,如:电商平台的交易系统/金融风控核心服务]。”

要点:直接、简洁,点名年限和核心领域。

第二部分:技术栈与核心技能 (45秒)

目的:展示你的技术广度和深度,证明你具备扎实的技术根基。

话术(请选择最擅长的点来说,不必全部罗列):

“在技术方面,我的技能栈主要集中在Java生态。”

【基础与框架】

- “我对 Java基础 有比较扎实的理解,熟悉JVM内存模型、垃圾回收机制以及多线程并发编程。”

- “熟练掌握主流开源框架,如 Spring全家桶(Spring, Spring MVC, Spring Boot),并理解其核心原理,比如Spring的IOC、AOP,以及Spring Boot的自动装配机制。”

【数据与存储】

- “在数据持久化方面,我精通 MyBatis,并对 MySQL 有丰富的使用和优化经验,包括索引优化、慢查询分析等。”

- “对分布式缓存 Redis 也很熟悉,用它来做过热点数据缓存、分布式锁等场景。”

【分布式与中间件】

- “在3年的项目中,我也接触并应用了一些分布式技术和中间件。比如使用 消息队列,来解决系统解耦和削峰填谷的问题。”

- “对微服务架构有实践经验,了解 Spring Cloud 的相关组件。”

要点:将技术分类,用“精通”、“熟练掌握”、“了解”等词语准确描述你的掌握程度。提到“原理”和“场景”能瞬间提升专业度。

第三部分:项目经验与价值贡献 (45秒)

目的:这是重中之重!通过1-2个最具代表性的项目,证明你能用技术解决实际问题。

话术(使用STAR法则简化版:情景、任务、行动、结果):

“在之前的工作中,我深度参与了一个[项目名称或类型]项目。我主要负责[你的核心职责]。”

【举例】: “比如,在去年的‘XX电商促销系统’中,我负责优化下单接口的性能。当时面临的主要问题是,在高并发下接口响应慢且超时率高。”

【行动与价值】:

- “我通过 线程池参数调优 和 数据库连接池优化,减少了线程上下文切换和等待时间。”

- “同时,我引入了 Redis缓存,将商品库存和用户信息等热点数据预热到缓存中,减少了对数据库的直接访问。”

- “通过这些优化,最终将下单接口的平均响应时间从500ms降低到了150ms,在峰值期间的系统稳定性也得到了大幅提升,顺利支撑了公司的大促活动。”

要点:一定要量化结果! 用“降低了XX%”、“提升了XX”、“支撑了XX QPS”这样的数据来展示你的贡献。

第四部分:职业动机与结尾 (15秒)

目的:表达你对新机会的渴望和与公司的契合度,并礼貌结尾。

话术:

“我目前正处于职业发展的上升期,非常渴望能加入一个像贵公司这样技术驱动、有挑战性的平台,与团队一起深入技术,创造更大的价值。”

“以上就是我的简单介绍,谢谢各位面试官。我带来的简历中有更详细的项目描述,非常期待后续的交流。”

要点:表达积极性和对公司的认可,将话题自然过渡到下一环节。

进阶技巧 & 注意事项

- 引导面试官:在介绍中“埋点”,引导到你准备充分的知识点。比如,你提到“用了Redis做分布式锁”,面试官很可能就会深入问你怎么实现的,有什么坑。

- 扬长避短:对于不熟悉的技术,不要夸大。可以说“有所了解,并在项目中简单应用过”,或者坦诚地说“这部分我还没有深入实践,但我对其原理很感兴趣”。

- 展现软实力:可以在项目部分不经意地提到“与产品、测试同事沟通”、“跨团队协作”等,体现你的团队协作能力。

- 差异化:如果你有亮点,一定要突出!比如:

- 性能优化狂人:“我曾将系统某个核心接口的TPS从100提升到2000。”

- 问题解决者:“我独立排查并解决过一个线上JVM Full GC频繁导致服务卡顿的疑难杂症。”

- 技术爱好者:“我有在技术博客上分享的习惯,GitHub上有X个Star。”

模板总结(直接套用版)

面试官好,我叫[姓名],有3年Java后端开发经验。过去主要在[上一家公司]负责[核心业务领域]相关的研发工作。

技术上,我基础比较扎实,熟悉JVM、多线程,精通Spring Boot、MyBatis等主流框架。对MySQL调优、Redis应用以及消息队列等中间件都有实践经验。

在项目中,我不仅完成日常开发,更注重解决技术难题。例如在[某项目]中,我通过[某项技术方案],成功将[某个指标]提升了[具体数据],保证了系统的稳定和高性能。

我关注到贵公司在[某个业务或技术点]方面做得很好,这非常吸引我。我希望能在这里深入发展,贡献我的力量。我的介绍就到这,谢谢。

项目介绍

采购公共服务系统(中台型系统)

参与的核心模块

- 供应商评估分类模块

- 统一权限管理模块

- 系统性能优化(贯穿各模块)

如何体现业务能力

不要说: "我写了供应商评估的CRUD接口。"

要这样说:

"我负责的供应商评估分类模块,是整个采购体系的决策中枢。它的业务价值在于,将原本依赖人工经验、标准不一的供应商评估,转变为一个自动化、标准化、可追溯的智能决策流程。

我解决的核心业务问题是:

- 评估标准不统一:不同采购员对供应商的打分标准不一。我通过设计可配置的打分模板,将评估指标和权重固化到系统中,保证了公平性。

- 数据孤岛:评估需要质量、财务、交付等多个部门的数据。我通过消息队列异步集成多个上游系统的数据,打破了部门墙,形成了对供应商的360度立体评估。

- 决策效率低下:手动评估一个供应商需要几天。系统实现后,评估周期缩短了70%,采购团队能更快地筛选出优质供应商。

这个模块直接带来的业务价值是:提升了供应商队伍的整体质量,降低了采购风险,并且为采购决策提供了数据支撑,而不再是‘拍脑袋’决定。"

业务细节深度剖析

1. 业务背景与痛点(展现你理解业务为什么存在)

"在我们集团原有的采购体系中,供应商评估存在三个核心痛点:

第一,标准不透明。 不同的采购事业部、甚至不同的采购员,对‘好供应商’的定义完全不同。A采购员看重价格,B采购员看重交期,导致评估结果无法横向对比,集团无法建立统一的供应商战略。

第二,数据孤岛。 评估需要的核心数据散落在多个系统中:

- 质量数据 在QMS(质量管理系统)中,包括来料合格率、生产过程中的PPM值。

- 财务数据 在SRM和财务系统中,包括开票准确性、付款周期。

- 交付数据 在WMS和TMS中,包括准时交付率、订单满足率。 采购员需要手动登录多个系统,复制粘贴数据到Excel里拼凑出一份评估报告,效率极低且容易出错。

第三,决策缺乏依据。 最终的供应商等级(比如A/B/C级)划分,很大程度上依赖采购经理的个人经验,缺乏数据支撑,存在主观性和潜在的合规风险。"

2. 我的技术实现如何解决业务痛点(展现你如何用技术赋能业务)

"我负责将这个混乱的流程系统化、自动化。我的核心工作不是简单的CRUD,而是将一个复杂的、依赖人脑判断的决策过程,抽象成一个可配置、可执行、可追溯的系统模型。

具体实现上,我设计了三个核心实体和它们之间的关系:

【评估模板】:这是业务的灵魂。我设计的数据库表结构,允许业务人员像搭积木一样配置模板。

template_id,template_name(模板基本信息)category_id(适用于什么品类的供应商,如电子类、结构件类)- 最关键的是

scoring_rules字段,它是一个JSON结构,定义了评分规则:json{ "indicators": [ { "name": "价格竞争力", "weight": 0.3, "dataSource": "QUOTATION_SYSTEM", "calculationRule": "AVG_PRICE_RANKING" // 规则:平均报价在所有供应商中的排名分 }, { "name": "质量合格率", "weight": 0.4, "dataSource": "QMS_SYSTEM", "calculationRule": "DIRECT_VALUE", // 规则:直接取值 "thresholds": [ {"score": 10, "condition": "value >= 99.5%"}, {"score": 8, "condition": "value >= 99%"}, {"score": 5, "condition": "value >= 98%"}, {"score": 0, "condition": "value < 98%"} ] }, { "name": "技术创新能力", "weight": 0.3, "dataSource": "MANUAL_INPUT", // 规则:需要专家手动打分 "scorers": ["ROLE_PURCHASING_MANAGER"] } ] }这个设计让业务规则实现了数据驱动,业务调整评估标准不再需要发版上线。

【数据集成流程】:为了解决数据孤岛问题,我设计了异步数据集成流。

- 实时数据:如订单状态变更,通过 RabbitMQ 发送领域事件,我们的系统消费后更新本地数据仓库。

- 批量数据:如月度质量报告,通过 FDI文件接口,由定时任务在凌晨同步。

- 关键实现:我使用了

CompletableFuture并行调用多个系统的/api/supplier/{id}/quality-stats等接口,将原本串行需要10秒的数据获取过程,压缩到了2秒内。【评估引擎】:这是系统的大脑。当触发评估时,引擎会:

- 根据模板ID加载评分规则。

- 根据规则里的

dataSource,从我们的数据仓库或实时接口获取数据。- 执行

calculationRule,为每个指标计算出原始分数。- 应用权重,计算出加权总分。

- 根据预设的等级阈值(如A级>90分,B级>75分),自动划定供应商等级。

- 整个计算过程在一个

@Transactional事务中完成,并记录下每一次评估的‘评估快照’,确保所有决策可审计、可追溯。"

3. 业务价值的具体量化(展现你的工作带来了什么)

"这个模块上线后,带来的改变是实实在在的:

- 效率提升:单个供应商的评估时间从平均3个工作日缩短到系统自动触发,分钟级出结果。

- 成本节约:采购团队每年因此节约的工时,折算人力成本约50万元/年。

- 决策质量:新供应商引入后的‘暴雷率’(即出现严重质量或交付问题)降低了25%,因为我们的评估模型提前识别了风险。

- 战略价值:集团终于可以拿出一张统一的‘供应商地图’,清晰地看到各个品类下的核心、战略、淘汰供应商,为集中采购和议价提供了数据武器。"

宏观到微观

第一层:项目背景(30秒 - 商业价值视角)

目标:用业务语言说清系统的定位和价值。

"我们先从项目背景说起。

在大型制造集团中,采购不是一个单一动作,而是涉及供应商管理、价格谈判、质量评估、合同审批等数十个环节的复杂体系。过去,每个业务部门都有自己的采购流程和供应商池,导致:

- 同一家供应商,在A部门是A级,在B部门却是C级

- 采购数据分散,集团无法集中议价,错失成本优化机会

- 风险不可控,出现过合作的供应商在其他子公司有不良记录

采购公共服务系统就是要解决这个问题,它将全集团所有采购相关的公共能力和基础数据统一管理,构建一个’采购中台’。"

要点:

- 从集团管控痛点切入

- 说明分散管理的弊端

- 明确"中台"定位

第二层:项目描述(1分钟 - 系统架构视角)

目标:描述系统技术架构和核心服务。

"从项目描述来看,这是一个典型的微服务中台架构。

系统采用 Spring Cloud Alibaba 体系,Nacos 作为服务注册发现和配置中心,Sentinel 负责流量控制。数据库使用 MySQL,缓存层是 Redis,异步通信通过 RabbitMQ 实现。

系统核心模块包括:

- 供应商主数据服务:全集团统一的供应商档案

- 权限管理服务:为所有采购相关系统提供统一的权限控制

- 模板引擎服务:可配置的评估模板、打分模板

- 业务群组服务:支持按事业部、项目灵活划分数据权限

- 白名单服务:集团级的供应商准入控制"

要点:

- 明确技术栈选型

- 列举核心微服务及其职责

- 体现"公共服务"特性

第三层:个人业务开发(1.5分钟 - 实现细节视角)

目标:具体说明负责的模块和技术实现。

"我主要负责供应商评估分类模块和系统性能优化。

供应商评估分类模块的业务目标是:将原本依赖个人经验的供应商评估,变成标准化、数据驱动的智能决策。

我的技术实现核心是一个可配置的规则引擎:

- 数据库设计中,我用JSON字段存储评分规则,支持灵活配置指标、权重、数据源和计算规则

- 通过策略模式实现不同的评分算法,如排名法、阈值法、专家打分法

- 评估执行时,使用

CompletableFuture并行获取质量、交付、财务等多维度数据- 整个评估过程在

@Transactional事务中完成,并记录完整的评估快照用于审计在系统性能优化方面,我建立了一套完整的优化方法论:

- 通过Redis缓存热点数据,将供应商信息的查询从50ms优化到2ms

- 对SQL执行计划进行分析,解决隐式转换、索引失效问题

- 对大表实施分库分表,对复杂查询实施读写分离

- 最终将核心接口的响应时间稳定控制在250ms以内"

要点:

- 具体的技术选型和设计模式

- 数据结构和算法思考

- 性能优化的系统性方法

第四层:解决的技术难题(2分钟 - 实战深度视角)

目标:深入技术难点和解决方案。

"我解决了几个关键的技术难题:

第一个是’复杂业务规则的抽象与执行’问题。

- 难点:不同品类的供应商评估标准完全不同,电子件看技术创新,结构件看成本控制,如何设计一个既灵活又高性能的规则引擎?

- 我的解决方案:

- 元数据驱动:将评估指标、权重、数据源、计算规则定义为元数据,存储在JSON配置中

- 策略模式+工厂模式:为不同类型的计算规则(直接取值、排名计算、阈值打分)实现不同的策略

- 并行数据获取:使用

CompletableFuture并行从质量系统、财务系统等获取数据- 结果:支持业务人员在不发版的情况下调整评估标准,评估计算性能在500ms内完成

第二个是’大规模代码重构与质量提升’问题。

- 难点:历史代码中存在40多个分散的定时任务,以及300多个深度嵌套的if-else

- 我的解决方案:

- 策略模式统一定时任务:将所有定时任务抽象为

ScheduledTask接口,统一管理和监控- 函数式编程重构条件逻辑:使用

Predicate和Function接口替换深层嵌套- 模板方法模式抽取公共逻辑:将重复的校验、审批流程抽象为模板

- 结果:代码量减少40%,可维护性大幅提升,新功能开发效率提高60%

第三个是’分布式环境下的数据权限’问题。

- 难点:A事业部的用户不能看到B事业部的供应商数据,但这种过滤不能在每个查询接口重复实现

- 我的解决方案:

- Spring AOP + 自定义注解:在DAO层通过切面自动注入数据权限过滤条件

- ThreadLocal传递用户上下文:在网关层解析用户权限,通过ThreadLocal传递到业务层

- Redis缓存权限规则:将用户-数据权限关系缓存到Redis,避免每次查询都访问数据库

- 结果:实现对业务代码透明的数据权限控制,性能影响<5%"

要点:

- 每个问题都有具体的技术难点描述

- 解决方案体现设计模式和架构思想

- 有量化的性能和改进指标

第五层:系统级难点与思考(1分钟 - 架构演进视角)

目标:讨论系统层面的架构挑战和思考。

"在系统架构层面,我们面临几个持续的挑战:

第一个是’数据一致性与性能的权衡’。

- 作为基础服务,我们对数据的准确性要求极高,但分布式事务的性能代价又难以接受

- 我们采用最终一致性为主,但在供应商状态变更等关键场景,仍需要短暂的数据同步窗口,这是个持续优化的平衡点

第二个是’API兼容性与技术债管理’。

- 作为被几十个系统依赖的中台,我们的API一旦发布就几乎不能下线

- 即使推出了v2接口,v1接口也不敢废弃,导致系统技术债持续累积。如何在推动下游升级和保持系统纯洁性之间找到平衡,是个管理难题

第三个是’缓存策略的极致优化’。

- 权限数据、配置数据等要求极高的实时性,但又是最高频的查询

- 我们通过多级缓存(本地缓存+Redis)来优化,但在集群环境下,本地缓存的一致性又成为新的问题。这是一个典型的复杂度转移案例

第四个是’监控与故障定位’。

- 当一个问题涉及权限服务、供应商服务、模板服务等多个微服务时,故障定位变得异常困难

- 我们虽然建立了链路追踪,但在高并发下,全量采集的性能开销又成为新的瓶颈"

要点:

- 体现对分布式系统本质问题的理解

- 展现架构权衡的思考

- 承认技术没有完美解决方案

模板

1. 项目背景(商业价值)

"这是集团级的采购中台系统。过去各业务部门采购流程分散,导致同一供应商评价标准不一、数据孤岛、风险不可控。我们构建这个’采购中台’,就是要实现全集团采购能力的统一管理和数据共享。"

2. 项目描述(技术架构)

"系统采用Spring Cloud Alibaba微服务架构,核心服务包括供应商主数据、统一权限管理、模板引擎、业务群组、白名单管理等。作为基础公共服务,被公司数十个业务系统依赖。"

3. 个人职责与业务开发

"我主要负责供应商评估分类模块和系统性能优化:

评估模块:我设计了一个可配置的规则引擎,用JSON存储评分规则,支持指标、权重、数据源的灵活配置,通过策略模式实现不同的评分算法。

性能优化:建立完整的优化体系,包括Redis缓存热点数据、SQL执行计划分析、分库分表、读写分离,将核心接口响应时间稳定控制在250ms内。"

4. 解决的技术难题

"复杂业务规则的抽象与执行:

- 难点:不同品类供应商评估标准完全不同

- 方案:元数据驱动 + 策略模式 + 并行数据获取

- 结果:支持不发版调整评估标准,计算性能在500ms内

大规模代码重构与质量提升:

- 难点:40多个分散定时任务,300多个深层if-else

- 方案:策略模式统一定时任务 + 函数式编程重构条件逻辑

- 结果:代码量减少40%,开发效率提升60%"

5. 系统级难点与思考

"API兼容性与技术债管理:作为被几十个系统依赖的中台,API一旦发布几乎不能下线,如何在推动升级和保持系统纯洁性间平衡是持续挑战。

缓存策略的极致优化:权限数据要求极高实时性又是最高频查询,多级缓存在集群环境下的一致性保障需要持续优化。"

深度技术面试详解

一、项目背景与商业价值(深入版)

采购公共服务系统是公司ERP系统的核心中台模块,旨在解决集团内部采购流程分散、数据孤岛、供应商管理不统一的问题。过去,各个事业部有自己的供应商池和评估标准,导致同一家供应商在不同部门的评级不同,集团无法集中议价,采购风险难以控制。该系统将全集团的供应商管理、权限控制、评估模板等公共能力下沉,为所有采购相关业务提供统一服务。

1.1 业务痛点深度分析

"在深入介绍前,我想先阐述这个系统解决的根本性业务问题:

数据孤岛与标准不一

- 各事业部独立维护供应商数据,同一供应商在不同系统中有不同ID和评级

- 缺乏统一的供应商准入标准,质量风险难以控制

- 采购数据分散,集团无法利用规模优势进行集中议价

流程效率低下

- 新供应商准入需要跨部门人工审批,周期长达2-3周

- 供应商评估依赖个人经验,缺乏客观量化标准

- 权限管理分散,每个系统都需要重复开发权限模块

合规与审计风险

- 采购决策缺乏完整的数据追溯链

- 敏感操作缺少统一的审计日志

- 难以满足上市公司的合规性要求"

1.2 中台战略定位

"我们的系统定位是采购能力中台,将通用的采购能力抽象为可复用的服务:

- 供应商主数据服务:全集团唯一的供应商信息源

- 统一权限服务:所有采购系统的单点权限控制

- 模板引擎服务:可配置的业务规则执行引擎

- 审计追踪服务:完整的操作日志和合规保障"

二、系统架构深度解析

2.1 微服务架构设计

// 系统核心服务划分

@SpringBootApplication

public class ProcurementPlatform {

// 1. 供应商主数据服务

@Bean public SupplierService supplierService() {

return new SupplierService(); // 供应商生命周期管理

}

// 2. 权限控制服务

@Bean public AuthorizationService authService() {

return new AuthorizationService(); // 统一的RBAC权限模型

}

// 3. 模板引擎服务

@Bean public TemplateEngineService templateService() {

return new TemplateEngineService(); // 可配置的业务规则

}

// 4. 业务群组服务

@Bean public BusinessGroupService groupService() {

return new BusinessGroupService(); // 多租户数据隔离

}

}2.2 技术栈选型考量

"我们在技术选型时重点考虑了中台系统的特殊要求:

Spring Cloud Alibaba体系

- Nacos:服务注册发现 + 配置中心,支持配置热更新

- Sentinel:流量控制、熔断降级,保障服务稳定性

- Seata:分布式事务,解决数据一致性问题(在关键业务中使用)

数据存储策略

- MySQL:核心业务数据,采用分库分表

- Redis:缓存热点数据 + 分布式会话 + 分布式锁

- Elasticsearch:供应商搜索和复杂查询

消息中间件

- RabbitMQ:业务解耦 + 最终一致性保障

- 采用确认机制确保消息不丢失"

三、核心模块技术实现

3.1 供应商评估分类模块(重点)

3.1.1 规则引擎设计

// 可配置的评估规则引擎核心实现

@Service

@Slf4j

public class SupplierEvaluationEngine {

@Autowired

private RedisTemplate<String, Object> redisTemplate;

@Autowired

private DataSourceRouter dataSourceRouter;

/**

* 执行供应商评估

*/

@Transactional

public EvaluationResult evaluateSupplier(Long supplierId, String templateCode) {

long startTime = System.currentTimeMillis();

try {

// 1. 加载评估模板

EvaluationTemplate template = loadEvaluationTemplate(templateCode);

// 2. 并行获取评估数据

Map<String, Object> evaluationData = fetchEvaluationDataParallel(supplierId, template);

// 3. 执行评分计算

ScoreResult scoreResult = calculateScores(template, evaluationData);

// 4. 确定供应商等级

SupplierLevel level = determineSupplierLevel(scoreResult.getTotalScore());

// 5. 保存评估结果和快照

return saveEvaluationResult(supplierId, template, scoreResult, level, evaluationData);

} finally {

log.info("供应商评估完成,supplierId: {}, 耗时: {}ms",

supplierId, System.currentTimeMillis() - startTime);

}

}

/**

* 并行获取多维度评估数据

*/

private Map<String, Object> fetchEvaluationDataParallel(Long supplierId,

EvaluationTemplate template) {

// 使用CompletableFuture并行调用多个数据源

List<CompletableFuture<DataFetchResult>> futures = template.getDataSources()

.stream()

.map(dataSource -> CompletableFuture.supplyAsync(() ->

fetchSingleDataSource(supplierId, dataSource), dataFetchExecutor))

.collect(Collectors.toList());

// 等待所有数据获取完成(设置超时)

try {

CompletableFuture.allOf(futures.toArray(new CompletableFuture[0]))

.get(10, TimeUnit.SECONDS);

} catch (TimeoutException e) {

log.warn("数据获取超时,将使用已获取的数据继续评估");

// 不抛出异常,使用已获取的数据继续评估

} catch (Exception e) {

throw new EvaluationException("数据获取失败", e);

}

// 聚合结果

Map<String, Object> result = new HashMap<>();

for (CompletableFuture<DataFetchResult> future : futures) {

if (future.isDone() && !future.isCompletedExceptionally()) {

try {

DataFetchResult dataResult = future.get();

result.put(dataResult.getDataSource(), dataResult.getData());

} catch (Exception e) {

log.warn("单个数据源获取失败", e);

}

}

}

return result;

}

}3.1.2 模板配置数据结构

// 评估模板的JSON配置结构

{

"templateCode": "ELECTRONIC_SUPPLIER_V1",

"templateName": "电子类供应商评估模板",

"applicableCategories": ["ELECTRONIC", "PCBA"],

"scoringRules": {

"indicators": [

{

"code": "QUALITY_PERFORMANCE",

"name": "质量表现",

"weight": 0.35,

"dataSource": "QMS_SYSTEM",

"calculationType": "THRESHOLD_SCORING",

"parameters": {

"dataField": "quality_qualified_rate",

"thresholds": [

{"min": 99.5, "score": 10, "level": "EXCELLENT"},

{"min": 99.0, "max": 99.5, "score": 8, "level": "GOOD"},

{"min": 98.0, "max": 99.0, "score": 6, "level": "AVERAGE"},

{"max": 98.0, "score": 0, "level": "POOR"}

]

}

},

{

"code": "TECHNICAL_CAPABILITY",

"name": "技术能力",

"weight": 0.25,

"dataSource": "MANUAL_SCORING",

"calculationType": "EXPERT_EVALUATION",

"parameters": {

"requiredRoles": ["TECHNICAL_MANAGER", "RD_DIRECTOR"],

"scoringRange": {"min": 0, "max": 10}

}

}

]

},

"levelSettings": {

"levels": [

{"level": "A", "minScore": 90, "privileges": ["PRIORITY_BIDDING", "LONG_TERM_CONTRACT"]},

{"level": "B", "minScore": 75, "maxScore": 90, "privileges": ["NORMAL_BIDDING"]},

{"level": "C", "minScore": 60, "maxScore": 75, "privileges": ["RESTRICTED_BIDDING"]},

{"level": "D", "maxScore": 60, "privileges": [], "actions": ["AUTO_REJECT"]}

]

}

}3.2 系统性能优化(深度实践)

3.2.1 多级缓存架构

@Service

public class MultiLevelCacheService {

@Autowired

private RedisTemplate<String, Object> redisTemplate;

// 本地缓存(Caffeine)

private final Cache<String, Object> localCache = Caffeine.newBuilder()

.maximumSize(1000)

.expireAfterWrite(5, TimeUnit.MINUTES)

.build();

/**

* 多级缓存查询

*/

public <T> T getWithMultiLevelCache(String key, Class<T> type,

Supplier<T> loader, Duration expiry) {

// 1. 查询本地缓存

T value = (T) localCache.getIfPresent(key);

if (value != null) {

metricService.recordCacheHit("local");

return value;

}

// 2. 查询Redis分布式缓存

String redisKey = "procurement:" + key;

value = (T) redisTemplate.opsForValue().get(redisKey);

if (value != null) {

// 回填本地缓存

localCache.put(key, value);

metricService.recordCacheHit("redis");

return value;

}

// 3. 缓存未命中,从数据源加载

value = loader.get();

if (value != null) {

// 异步写入缓存

CompletableFuture.runAsync(() -> {

// 写入Redis,设置过期时间

redisTemplate.opsForValue().set(redisKey, value, expiry);

// 写入本地缓存

localCache.put(key, value);

}, cacheExecutor);

}

metricService.recordCacheMiss();

return value;

}

/**

* 缓存一致性保障 - 发布缓存失效事件

*/

@EventListener

public void handleDataChangeEvent(DataChangedEvent event) {

String cacheKey = buildCacheKey(event.getEntityType(), event.getEntityId());

// 1. 删除本地缓存

localCache.invalidate(cacheKey);

// 2. 发布Redis消息,通知其他实例失效本地缓存

redisTemplate.convertAndSend("cache.invalidation", cacheKey);

// 3. 删除Redis缓存

redisTemplate.delete("procurement:" + cacheKey);

}

}3.2.2 SQL优化实战

-- 优化前的慢查询

SELECT * FROM supplier_evaluation

WHERE supplier_id IN (SELECT supplier_id FROM supplier WHERE category = 'ELECTRONIC')

AND evaluation_date BETWEEN '2023-01-01' AND '2023-12-31'

ORDER BY total_score DESC;

-- 优化后的查询

-- 1. 创建复合索引

CREATE INDEX idx_supplier_evaluation_composite

ON supplier_evaluation(supplier_id, evaluation_date, total_score);

-- 2. 使用JOIN替代子查询

SELECT se.* FROM supplier_evaluation se

INNER JOIN supplier s ON se.supplier_id = s.supplier_id

WHERE s.category = 'ELECTRONIC'

AND se.evaluation_date BETWEEN '2023-01-01' AND '2023-12-31'

ORDER BY se.total_score DESC;

-- 3. 分页优化 - 使用游标分页替代LIMIT OFFSET

SELECT * FROM supplier_evaluation

WHERE supplier_id > ? AND evaluation_date BETWEEN ? AND ?

ORDER BY supplier_id LIMIT 1000;四、解决的核心技术难题

4.1 分布式数据权限控制

4.1.1 架构设计

// 基于Spring AOP的数据权限切面

@Aspect

@Component

public class DataPermissionAspect {

@Around("@annotation(dataPermission)")

public Object applyDataPermission(ProceedingJoinPoint joinPoint,

DataPermission dataPermission) throws Throwable {

// 1. 获取当前用户权限上下文

UserContext userContext = SecurityContextHolder.getUserContext();

// 2. 解析数据权限规则

DataPermissionRule rule = parsePermissionRule(dataPermission, userContext);

// 3. 修改SQL查询条件

modifyQueryForDataPermission(joinPoint, rule);

// 4. 执行原方法

return joinPoint.proceed();

}

private void modifyQueryForDataPermission(ProceedingJoinPoint joinPoint,

DataPermissionRule rule) {

Object[] args = joinPoint.getArgs();

for (int i = 0; i < args.length; i++) {

if (args[i] instanceof DataQuery) {

DataQuery query = (DataQuery) args[i];

// 动态添加数据权限过滤条件

query.addFilter(buildDataPermissionFilter(rule));

break;

}

}

}

}

// 数据权限规则配置

@Entity

@Table(name = "data_permission_rule")

public class DataPermissionRule {

@Id

private Long id;

// 规则类型:用户级、部门级、业务群组级

@Enumerated(EnumType.STRING)

private RuleType ruleType;

// 目标数据类型:供应商、报价单、合同等

private String dataType;

// 权限条件(SQL WHERE片段)

private String permissionCondition;

// JSON配置,支持复杂规则

@Column(columnDefinition = "json")

private String ruleConfig;

}4.1.2 性能优化策略

@Service

public class DataPermissionOptimizer {

// 权限规则缓存

private final LoadingCache<String, List<DataPermissionRule>> permissionCache =

Caffeine.newBuilder()

.maximumSize(100)

.refreshAfterWrite(10, TimeUnit.MINUTES)

.build(this::loadPermissionRules);

/**

* 预编译数据权限过滤器,避免每次查询都解析规则

*/

public DataFilter compileDataFilter(UserContext userContext, String dataType) {

String cacheKey = buildCacheKey(userContext, dataType);

return permissionCache.get(cacheKey).stream()

.map(this::convertRuleToFilter)

.reduce(DataFilter::and)

.orElse(DataFilter.EMPTY);

}

}4.2 大规模代码重构与质量提升

4.2.1 定时任务统一管理

// 定时任务统一接口

public interface ScheduledTask {

String getTaskName();

String getCronExpression();

void execute();

default boolean isEnabled() { return true; }

}

// 定时任务执行器

@Service

public class UnifiedScheduler {

@Autowired

private List<ScheduledTask> scheduledTasks;

@PostConstruct

public void scheduleAllTasks() {

scheduledTasks.stream()

.filter(ScheduledTask::isEnabled)

.forEach(this::scheduleTask);

}

private void scheduleTask(ScheduledTask task) {

// 使用ScheduledExecutorService统一调度

// 添加监控和异常处理

scheduledExecutor.scheduleWithFixedDelay(() -> {

try {

metricService.recordTaskStart(task.getTaskName());

task.execute();

metricService.recordTaskSuccess(task.getTaskName());

} catch (Exception e) {

metricService.recordTaskFailure(task.getTaskName());

log.error("定时任务执行失败: {}", task.getTaskName(), e);

}

}, 0, getDelaySeconds(task.getCronExpression()), TimeUnit.SECONDS);

}

}4.2.2 复杂条件逻辑重构

// 重构前 - 深层嵌套的if-else

public class OldEvaluationService {

public ScoreResult evaluate(Supplier supplier, EvaluationContext context) {

if (supplier.getCategory().equals("ELECTRONIC")) {

if (context.isQualityCheckRequired()) {

if (supplier.getQualityScore() > 8.0) {

if (supplier.getDeliveryPerformance() > 95.0) {

// ... 更多嵌套

}

}

}

} else if (supplier.getCategory().equals("MECHANICAL")) {

// 另一个复杂的条件分支

}

// ... 总共300多行深层嵌套

}

}

// 重构后 - 使用函数式编程和策略模式

@Service

public class RefactoredEvaluationService {

private final Map<String, EvaluationStrategy> strategies;

public ScoreResult evaluate(Supplier supplier, EvaluationContext context) {

return strategies.get(supplier.getCategory())

.evaluate(supplier, context);

}

}

// 策略接口

public interface EvaluationStrategy {

ScoreResult evaluate(Supplier supplier, EvaluationContext context);

}

// 具体策略实现

@Component

public class ElectronicSupplierStrategy implements EvaluationStrategy {

private final List<EvaluationRule<Supplier>> rules = Arrays.asList(

this::checkQualityRequirement,

this::checkDeliveryPerformance,

this::checkTechnicalCapability

);

@Override

public ScoreResult evaluate(Supplier supplier, EvaluationContext context) {

return rules.stream()

.map(rule -> rule.apply(supplier, context))

.reduce(ScoreResult::combine)

.orElse(ScoreResult.EMPTY);

}

private ScoreResult checkQualityRequirement(Supplier supplier, EvaluationContext context) {

return context.isQualityCheckRequired() && supplier.getQualityScore() > 8.0 ?

ScoreResult.passing("质量达标") : ScoreResult.failing("质量不达标");

}

}五、系统级架构挑战与解决方案

5.1 数据一致性保障

5.1.1 最终一致性模式

// 基于消息队列的最终一致性实现

@Service

@Transactional

public class EventuallyConsistentService {

@Autowired

private RabbitTemplate rabbitTemplate;

/**

* 创建供应商(核心事务+事件发布)

*/

public Supplier createSupplier(CreateSupplierRequest request) {

// 1. 核心数据写入(强一致性)

Supplier supplier = supplierRepository.save(convertToEntity(request));

// 2. 发布领域事件

SupplierCreatedEvent event = new SupplierCreatedEvent(supplier.getId());

rabbitTemplate.convertAndSend("supplier.exchange", "supplier.created", event);

// 3. 记录本地事件表(防消息丢失)

eventRepository.save(new DomainEvent(event));

return supplier;

}

/**

* 事件处理 - 更新相关系统的数据

*/

@RabbitListener(queues = "supplier.created.queue")

public void handleSupplierCreated(SupplierCreatedEvent event) {

try {

// 更新搜索索引

searchService.indexSupplier(event.getSupplierId());

// 通知风控系统

riskControlService.onNewSupplier(event.getSupplierId());

// 标记事件已处理

eventRepository.markAsProcessed(event.getEventId());

} catch (Exception e) {

// 记录失败,进入重试机制

log.error("处理供应商创建事件失败", e);

throw new AmqpRejectAndDontRequeueException(e);

}

}

}5.2 高可用与容灾设计

5.2.1 服务降级与熔断

// 基于Sentinel的服务保护

@Service

public class ProtectedSupplierService {

@SentinelResource(

value = "supplierQuery",

fallback = "getSupplierFallback",

blockHandler = "handleFlowControl"

)

public Supplier getSupplier(Long supplierId) {

// 正常业务逻辑

return supplierRepository.findById(supplierId)

.orElseThrow(() -> new SupplierNotFoundException(supplierId));

}

// 降级逻辑

public Supplier getSupplierFallback(Long supplierId, Throwable ex) {

log.warn("供应商查询降级,supplierId: {}", supplierId, ex);

// 返回降级数据

Supplier fallback = new Supplier();

fallback.setId(supplierId);

fallback.setName("供应商信息暂不可用");

fallback.setStatus(SupplierStatus.UNKNOWN);

return fallback;

}

// 流控处理

public Supplier handleFlowControl(Long supplierId, BlockException ex) {

throw new ServiceBusyException("系统繁忙,请稍后重试");

}

}六、量化成果与业务影响

6.1 性能指标提升

- 接口响应时间:核心接口从平均800ms优化到250ms以内

- 系统吞吐量:从500 TPS提升到2000 TPS

- 缓存命中率:达到98.5%,数据库压力降低70%

- 任务执行效率:批量评估任务从小时级优化到分钟级

6.2 业务价值体现

- 采购效率:供应商准入周期从3周缩短到3天

- 决策质量:基于数据的客观评估,供应商"暴雷率"降低25%

- 成本节约:集中议价每年为集团节约采购成本约8%

- 合规性:实现100%操作可审计,满足上市合规要求

6.3 技术债务清理

- 代码质量:代码重复率从35%降低到8%

- 可维护性:新功能开发效率提升60%

- 系统稳定性:线上故障率降低80%

这个深度技术详解展现了你在架构设计、性能优化、复杂问题解决方面的全面能力,让面试官看到你不仅是一个编码实现者,更是一个系统架构师和问题解决专家。

高并发处理能力与优化

1. 高并发场景分析

读多写少是其典型特征:

- 高频读操作(占比>90%):权限验证、供应商信息查询、配置数据读取

- 低频写操作:供应商信息变更、评估结果提交、权限配置更新

- 特点:请求量大、响应要求高、数据一致性要求强

2. 四层性能优化体系

第一层:缓存优化体系(解决读压力)

// 1. 多级缓存架构实现

@Service

public class ProcurementCacheService {

// 一级缓存:本地缓存(Caffeine),5分钟过期

private final Cache<String, Object> localCache = Caffeine.newBuilder()

.maximumSize(10_000)

.expireAfterWrite(5, TimeUnit.MINUTES)

.recordStats() // 记录缓存命中率

.build();

// 二级缓存:Redis集群

@Autowired

private RedisTemplate<String, Object> redisTemplate;

/**

* 带降级的多级缓存查询

*/

public <T> T getWithGracefulDegradation(String key, Supplier<T> loader,

Class<T> type, Duration expiry) {

// 第1步:本地缓存(最快,<1ms)

T value = (T) localCache.getIfPresent(key);

if (value != null) {

metrics.recordCacheHit("local");

return value;

}

// 第2步:分布式锁防止缓存击穿

String lockKey = "lock:cache:" + key;

RLock lock = redissonClient.getLock(lockKey);

try {

// 尝试获取锁,等待100ms,锁持有300ms

if (lock.tryLock(100, 300, TimeUnit.MILLISECONDS)) {

// 第3步:Redis缓存(<5ms)

value = (T) redisTemplate.opsForValue().get(buildRedisKey(key));

if (value != null) {

// 回填本地缓存

localCache.put(key, value);

metrics.recordCacheHit("redis");

return value;

}

// 第4步:数据库查询(最慢,20-100ms)

try {

value = loader.get();

if (value != null) {

// 异步双写缓存(不阻塞主流程)

CompletableFuture.runAsync(() -> {

redisTemplate.opsForValue().set(

buildRedisKey(key),

value,

expiry

);

localCache.put(key, value);

}, cacheWriteExecutor);

}

return value;

} catch (Exception e) {

// 第5步:降级方案 - 返回过期的缓存数据

T staleValue = getStaleDataFromBackup(key);

metrics.recordCacheDegradation();

return staleValue;

}

} else {

// 获取锁失败,直接返回降级数据

return getStaleDataFromBackup(key);

}

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

return getStaleDataFromBackup(key);

} finally {

if (lock.isHeldByCurrentThread()) {

lock.unlock();

}

}

}

/**

* 缓存预热机制(应对早高峰)

*/

@Scheduled(cron = "0 30 6 * * ?") // 每天6:30执行

public void preheatCache() {

// 预热高频查询数据

List<String> hotKeys = identifyHotKeys();

hotKeys.parallelStream().forEach(key -> {

// 异步预热

CompletableFuture.runAsync(() -> {

Object data = loadDataFromDB(key);

if (data != null) {

redisTemplate.opsForValue().set(buildRedisKey(key), data, 2, TimeUnit.HOURS);

}

}, preheatExecutor);

});

}

}第二层:数据库优化

-- 1. 读写分离配置

-- 主库(写):1主 | 从库(读):3从

-- 使用ShardingSphere进行自动路由

-- 2. 分库分表策略(供应商表,数据量:5000万+)

CREATE TABLE supplier_00 (

supplier_id BIGINT PRIMARY KEY,

supplier_code VARCHAR(50),

-- ... 其他字段

shard_key INT AS (supplier_id % 16) -- 虚拟列用于分片

) PARTITION BY KEY(shard_key) PARTITIONS 16;

-- 3. 索引优化(覆盖索引)

CREATE INDEX idx_supplier_query ON supplier_00

(supplier_status, category_id, create_time)

INCLUDE (supplier_name, credit_level); -- 包含查询所需的所有列

-- 4. 垂直拆分(大字段分离)

-- supplier_basic:基础信息,高频查询

-- supplier_detail:详细信息(公司介绍、资质文件等),低频查询

-- supplier_statistics:统计信息,用于报表第三层:应用层优化

// 1. 连接池优化(HikariCP配置)

@Bean

public DataSource dataSource() {

HikariConfig config = new HikariConfig();

config.setJdbcUrl(jdbcUrl);

config.setUsername(username);

config.setPassword(password);

config.setMaximumPoolSize(50); // 根据CPU核心数调整

config.setMinimumIdle(10);

config.setConnectionTimeout(30000); // 30秒超时

config.setIdleTimeout(600000); // 10分钟

config.setMaxLifetime(1800000); // 30分钟

config.setConnectionTestQuery("SELECT 1");

config.setPoolName("ProcurementPool");

// 监控连接池状态

config.addDataSourceProperty("metrics", "true");

config.addDataSourceProperty("metricRegistry", metricRegistry);

return new HikariDataSource(config);

}

// 2. 线程池隔离(不同业务使用不同线程池)

@Configuration

public class ThreadPoolConfiguration {

// 核心业务线程池(快速响应)

@Bean("coreBusinessExecutor")

public ThreadPoolTaskExecutor coreBusinessExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(20);

executor.setMaxPoolSize(50);

executor.setQueueCapacity(1000);

executor.setThreadNamePrefix("core-business-");

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());

return executor;

}

// 批量处理线程池(允许堆积)

@Bean("batchProcessingExecutor")

public ThreadPoolTaskExecutor batchProcessingExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(5);

executor.setMaxPoolSize(10);

executor.setQueueCapacity(5000); // 大队列,允许任务堆积

executor.setThreadNamePrefix("batch-process-");

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.AbortPolicy());

return executor;

}

}

// 3. 异步化处理

@Service

public class AsyncAssessmentService {

@Autowired

private ThreadPoolTaskExecutor batchProcessingExecutor;

/**

* 异步批量评估(应对评估高峰期)

*/

@Async("batchProcessingExecutor")

public CompletableFuture<BatchResult> asyncBatchAssessment(List<Long> supplierIds) {

// 使用分治策略:每100个供应商一批

List<List<Long>> batches = Lists.partition(supplierIds, 100);

List<CompletableFuture<AssessmentResult>> futures = batches.stream()

.map(batch -> CompletableFuture.supplyAsync(() ->

processBatchAssessment(batch), batchProcessingExecutor))

.collect(Collectors.toList());

// 等待所有批次完成,但设置超时

return CompletableFuture.allOf(futures.toArray(new CompletableFuture[0]))

.orTimeout(5, TimeUnit.MINUTES) // 5分钟超时

.thenApply(v -> aggregateResults(futures));

}

}第四层:应急与降级

// 1. 熔断降级(Sentinel配置)

@Service

public class SupplierServiceWithCircuitBreaker {

@SentinelResource(

value = "supplierQueryResource",

fallback = "querySupplierFallback",

blockHandler = "handleFlowControl",

exceptionsToIgnore = {IllegalArgumentException.class}

)

public Supplier getSupplierWithProtection(Long supplierId) {

// 正常业务逻辑

return supplierRepository.findById(supplierId)

.orElseThrow(() -> new SupplierNotFoundException(supplierId));

}

// 降级方法:返回简化数据

public Supplier querySupplierFallback(Long supplierId, Throwable ex) {

log.warn("供应商查询降级,返回简化数据,supplierId: {}", supplierId);

Supplier simplified = new Supplier();

simplified.setId(supplierId);

simplified.setName("供应商信息加载中...");

simplified.setStatus(SupplierStatus.UNKNOWN);

// 记录降级事件,用于后续补偿

degradeEventRepository.save(new DegradeEvent("supplier_query", supplierId));

return simplified;

}

// 流控处理

public Supplier handleFlowControl(Long supplierId, BlockException ex) {

throw new ServiceDegradeException("系统繁忙,请稍后重试");

}

}

// 2. 限流策略

@Component

public class RateLimitConfiguration {

@Bean

public RateLimiter supplierQueryRateLimiter() {

// 令牌桶算法:每秒100个令牌,桶容量200

return RateLimiter.create(100.0, 200, TimeUnit.MILLISECONDS);

}

@Before("execution(* com..SupplierService.*(..))")

public void checkRateLimit(JoinPoint joinPoint) {

if (!supplierQueryRateLimiter.tryAcquire()) {

throw new RateLimitExceededException("请求过于频繁,请稍后重试");

}

}

}分库分表与读写分离设计决策

一、核心设计原则:基于什么去做?

我们的设计决策基于四个核心维度:

- 业务特征驱动

- 数据访问模式分析(读写比例、热点分布)

- 业务增长预测(数据量、并发量趋势)

- 服务等级要求(SLA、一致性要求)

- 数据特征分析

- 数据生命周期(冷热数据、归档策略)

- 数据关联关系(主子表、查询关联性)

- 数据增长速率(年增长率、峰值预测)

- 技术约束考量

- 单机性能极限(MySQL单表容量、连接数限制)

- 运维复杂度(扩缩容难度、故障恢复)

- 成本效益(硬件成本 vs 性能收益)

- 组织架构匹配

- 业务部门边界(不同事业部数据隔离需求)

- 合规性要求(数据安全、审计隔离)

二、分库设计:为什么分?如何分?

2.1 垂直分库(按业务域拆分)

决策依据:

-- 数据访问统计(监控数据分析)

SELECT

table_name,

SUM(select_count) as read_ops,

SUM(update_count + insert_count + delete_count) as write_ops,

AVG(row_count) as avg_rows,

data_size_gb

FROM table_stats

WHERE schema_name = 'procurement'

GROUP BY table_name

ORDER BY read_ops DESC;

-- 结果示例:

-- 1. supplier_main: 读操作 500万/天,写操作 1万/天 → 读密集型

-- 2. permission_data: 读操作 1000万/天,写操作 5千/天 → 极高频读

-- 3. operation_log: 读操作 10万/天,写操作 100万/天 → 写密集型

-- 4. assessment_result: 读操作 200万/天,写操作 50万/天 → 读写均衡分库方案:

// 按业务域垂直分库

public enum DatabaseShard {

// 核心业务库 - 高频读写,需要强一致性

CORE_BUSINESS("core_db", Arrays.asList(

"supplier_main", // 供应商主数据

"supplier_category", // 供应商分类

"white_list" // 白名单

)),

// 权限配置库 - 超高频率读,变更较少

AUTHORIZATION("auth_db", Arrays.asList(

"user_permission", // 用户权限

"role_definition", // 角色定义

"data_scope_rule" // 数据范围规则

)),

// 模板引擎库 - 读多写少,配置型数据

TEMPLATE("template_db", Arrays.asList(

"assessment_template", // 评估模板

"scoring_rule", // 打分规则

"workflow_definition" // 工作流定义

)),

// 日志操作库 - 写密集型,允许异步

OPERATION_LOG("log_db", Arrays.asList(

"operation_log", // 操作日志

"audit_trail", // 审计追踪

"system_event" // 系统事件

)),

// 统计分析库 - 复杂查询,允许延迟

ANALYTICS("analytics_db", Arrays.asList(

"supplier_statistics", // 供应商统计

"performance_metric", // 绩效指标

"trend_analysis" // 趋势分析

));

private final String dbName;

private final List<String> tables;

}设计理由:

- 资源隔离:避免日志写入影响核心交易查询

- 专业优化:每个库可根据自身特点优化(如log_db用机械硬盘,auth_db用SSD)

- 独立扩缩容:权限库压力大时可单独扩容

- 故障隔离:单个库故障不影响其他业务

三、分表设计:基于数据的自然分布

3.1 供应商表分表策略

决策数据依据:

-- 分析供应商数据特征

SELECT

-- 数据分布

COUNT(*) as total_suppliers,

COUNT(DISTINCT business_group_id) as business_groups,

-- 访问热度分析

SUM(CASE WHEN last_access_date > NOW() - INTERVAL 7 DAY THEN 1 ELSE 0 END) as active_7days,

SUM(CASE WHEN last_access_date > NOW() - INTERVAL 30 DAY THEN 1 ELSE 0 END) as active_30days,

-- 数据大小

AVG(JSON_LENGTH(supplier_metadata)) as avg_metadata_size,

-- 关联查询分析

(SELECT COUNT(*) FROM quotation WHERE supplier_id IS NOT NULL) / COUNT(*) as avg_quotation_per_supplier

FROM supplier_main;分表方案:

// 基于复合维度的分表策略

public class SupplierShardingStrategy {

/**

* 分表键设计:复合分片键 (业务群组 + 供应商类型 + 时间)

*/

public String determineTableName(Supplier supplier) {

// 维度1:业务群组(天然的业务隔离边界)

String businessGroup = supplier.getBusinessGroupCode();

// 维度2:供应商类型(不同类型访问模式不同)

SupplierType type = supplier.getType();

// 维度3:创建时间(时间序列,便于归档)

LocalDateTime createTime = supplier.getCreateTime();

// 分表逻辑

if (isLargeEnterprise(supplier)) {

// 大企业供应商:单独分表(数据量大,访问频繁)

return "supplier_large_enterprise";

}

// 普通供应商:按业务群组分片

int shardIndex = Math.abs(businessGroup.hashCode()) % 16;

// 按时间分表(每月一张)

String timeSuffix = createTime.format(DateTimeFormatter.ofPattern("yyyyMM"));

return String.format("supplier_%s_%02d_%s",

type.getCode().toLowerCase(),

shardIndex,

timeSuffix);

}

/**

* 大供应商判断标准(基于业务规则)

*/

private boolean isLargeEnterprise(Supplier supplier) {

return supplier.getAnnualProcurementAmount() > 100_000_000 || // 年采购额>1亿

supplier.getEmployeeCount() > 1000 || // 员工数>1000

supplier.isStrategicPartner(); // 战略合作伙伴

}

}3.2 操作日志表分表策略

决策依据:

-- 日志数据特征分析

SELECT

DATE(create_time) as log_date,

COUNT(*) as log_count,

AVG(LENGTH(operation_content)) as avg_content_length,

COUNT(DISTINCT user_id) as active_users,

COUNT(DISTINCT operation_type) as operation_types

FROM operation_log

WHERE create_time >= NOW() - INTERVAL 90 DAY

GROUP BY DATE(create_time)

ORDER BY log_date DESC;分表方案:

-- 按时间范围分表 + 按操作类型哈希分表(二级分片)

-- 主表按月分区

CREATE TABLE operation_log_202401 (

id BIGINT AUTO_INCREMENT,

operation_type VARCHAR(50),

user_id BIGINT,

operation_time DATETIME,

content JSON,

-- 二级分片键:按操作类型哈希

shard_key TINYINT AS (

CASE operation_type

WHEN 'SUPPLIER_CREATE' THEN 1

WHEN 'SUPPLIER_UPDATE' THEN 2

WHEN 'ASSESSMENT_SUBMIT' THEN 3

-- ... 其他类型

ELSE MOD(CRC32(operation_type), 8) + 10

END

) STORED,

PRIMARY KEY (id, shard_key),

INDEX idx_time_user (operation_time, user_id),

INDEX idx_type_time (operation_type, operation_time)

)

PARTITION BY RANGE (TO_DAYS(operation_time)) (

PARTITION p20240101 VALUES LESS THAN (TO_DAYS('2024-01-08')),

PARTITION p20240108 VALUES LESS THAN (TO_DAYS('2024-01-15')),

PARTITION p20240115 VALUES LESS THAN (TO_DAYS('2024-01-22')),

PARTITION p20240122 VALUES LESS THAN (TO_DAYS('2024-01-29')),

PARTITION p20240129 VALUES LESS THAN (TO_DAYS('2024-02-01'))

);

-- 创建分表(按shard_key分散到不同物理表)

CREATE TABLE operation_log_202401_shard1 LIKE operation_log_202401;

CREATE TABLE operation_log_202401_shard2 LIKE operation_log_202401;

-- ... 创建8个分表四、读写分离设计:基于访问模式

4.1 读写分离策略矩阵

/**

* 基于业务场景的读写路由决策器

*/

@Component

public class ReadWriteRouter {

// 配置:哪些场景强制读主库

@Value("${database.force-master-patterns}")

private List<String> forceMasterPatterns;

// 配置:哪些场景允许读从库

@Value("${database.allow-slave-patterns}")

private List<String> allowSlavePatterns;

/**

* 路由决策逻辑

*/

public DataSource determineDataSource(RoutingContext context) {

// 规则1:写操作强制走主库

if (context.isWriteOperation()) {

metrics.recordRouteDecision("write_to_master");

return dataSourceManager.getMaster();

}

// 规则2:事务中的读操作走主库(避免不可重复读)

if (context.isInTransaction()) {

metrics.recordRouteDecision("transaction_to_master");

return dataSourceManager.getMaster();

}

// 规则3:刚写入后的读取走主库(解决主从延迟)

if (isFreshWrite(context)) {

metrics.recordRouteDecision("fresh_read_to_master");

return dataSourceManager.getMaster();

}

// 规则4:关键业务数据走主库

if (isCriticalBusinessData(context)) {

metrics.recordRouteDecision("critical_to_master");

return dataSourceManager.getMaster();

}

// 规则5:复杂查询走专门的分析从库

if (isComplexAnalyticsQuery(context)) {

metrics.recordRouteDecision("analytics_to_slave");

return dataSourceManager.getAnalyticsSlave();

}

// 规则6:默认按负载均衡选择从库

metrics.recordRouteDecision("load_balance_to_slave");

return dataSourceManager.getLoadBalancedSlave();

}

/**

* 判断是否为"刚写入"的读取

*/

private boolean isFreshWrite(RoutingContext context) {

String cacheKey = "recent_write:" + context.getUserId();

Long lastWriteTime = (Long) redisTemplate.opsForValue().get(cacheKey);

if (lastWriteTime == null) {

return false;

}

// 如果最近30秒内有写入,则认为是新鲜读取

return System.currentTimeMillis() - lastWriteTime < 30_000;

}

}4.2 从库集群架构

# 从库集群配置(基于不同用途)

database:

slaves:

# 实时业务从库(低延迟,强一致性)

business-realtime:

- host: slave1-biz.example.com

role: realtime

max-lag: 1000 # 最大延迟1秒

weight: 40 # 负载权重

- host: slave2-biz.example.com

role: realtime

max-lag: 1000

weight: 40

# 报表分析从库(允许延迟,高计算资源)

analytics:

- host: slave1-analytics.example.com

role: analytics

max-lag: 30000 # 允许30秒延迟

weight: 10

config:

max-connections: 200

query-timeout: 300s # 长查询超时

# 备份从库(用于数据同步、备份)

backup:

- host: slave1-backup.example.com

role: backup

max-lag: 60000 # 允许1分钟延迟

weight: 10

read-only: false # 允许写操作(用于ETL)五、监控与动态调整

5.1 分片热点监控

/**

* 分片热点检测与自动平衡

*/

@Component

@Slf4j

public class ShardHotspotMonitor {

@Autowired

private MetricRegistry metricRegistry;

@Scheduled(fixedDelay = 60000) // 每分钟检查一次

public void monitorShardDistribution() {

Map<String, ShardMetrics> shardMetrics = collectShardMetrics();

shardMetrics.forEach((shardName, metrics) -> {

// 检测热点分片

if (isHotShard(metrics)) {

log.warn("检测到热点分片: {},QPS: {},数据量: {},连接数: {}",

shardName,

metrics.getQps(),

metrics.getDataSize(),

metrics.getConnectionCount());

// 自动触发分片分裂

if (shouldSplitShard(metrics)) {

splitShard(shardName);

}

}

// 检测冷分片

if (isColdShard(metrics)) {

log.info("检测到冷分片: {},考虑合并", shardName);

scheduleShardMerge(shardName);

}

});

}

private boolean isHotShard(ShardMetrics metrics) {

// 热点判断标准

return metrics.getQps() > 1000 || // QPS > 1000

metrics.getDataSize() > 50_000_000 || // 数据量 > 5000万行

metrics.getConnectionCount() > 100; // 连接数 > 100

}

private boolean shouldSplitShard(ShardMetrics metrics) {

// 分片分裂条件

return metrics.getQps() > 5000 || // QPS > 5000

metrics.getDataSize() > 100_000_000 || // 数据量 > 1亿行

metrics.getGrowthRate() > 0.3; // 周增长率 > 30%

}

}5.2 读写分离质量监控

-- 读写分离质量分析SQL

WITH read_write_stats AS (

-- 主从延迟监控

SELECT

slave_host,

TIMESTAMPDIFF(SECOND, master_log_pos, slave_log_pos) as replication_lag_seconds,

CASE

WHEN TIMESTAMPDIFF(SECOND, master_log_pos, slave_log_pos) > 10 THEN 'CRITICAL'

WHEN TIMESTAMPDIFF(SECOND, master_log_pos, slave_log_pos) > 3 THEN 'WARNING'

ELSE 'HEALTHY'

END as lag_status

FROM replication_status

UNION ALL

-- 读写比例监控

SELECT

'ALL' as slave_host,

SUM(read_queries) / NULLIF(SUM(write_queries), 0) as read_write_ratio,

'N/A' as lag_status

FROM performance_schema.events_statements_summary_global_by_event_name

WHERE event_name LIKE 'statement/sql/%'

UNION ALL

-- 路由决策统计

SELECT

route_target as slave_host,

COUNT(*) as request_count,

AVG(response_time_ms) as avg_response_time

FROM request_routing_log

WHERE timestamp > NOW() - INTERVAL 1 HOUR

GROUP BY route_target

)

SELECT

slave_host,

AVG(replication_lag_seconds) as avg_lag,

MAX(CASE WHEN lag_status = 'CRITICAL' THEN 1 ELSE 0 END) as has_critical_lag,

read_write_ratio,

request_count,

avg_response_time

FROM read_write_stats

GROUP BY slave_host, read_write_ratio, request_count, avg_response_time

ORDER BY avg_lag DESC;六、决策总结与演进路径

6.1 为什么做出这些决策?

| 决策 | 基于的数据/事实 | 预期收益 | 已知风险 | 缓解措施 |

|---|---|---|---|---|

| 垂直分库 | 监控显示不同表访问模式差异大(权限表QPS 10k+,日志表TPS 1k+) | 资源隔离,独立扩缩容 | 跨库事务复杂 | 减少跨库事务,使用最终一致性 |

| 供应商表按业务群组分片 | 80%的查询带有business_group_id条件 | 查询性能提升60% | 跨群组查询变慢 | 建立跨分片索引,使用ES辅助查询 |

| 日志表按月分表 | 日志查询95%按时间范围,每月数据量500GB | 单表大小可控,备份恢复快 | 跨月查询需要UNION | 建立聚合视图,使用分区表 |

| 读写分离 | 读写比例 98:2,高峰读QPS 5000+ | 读性能提升300%,主库压力降70% | 主从延迟导致脏读 | 关键读操作强制主库,监控延迟 |

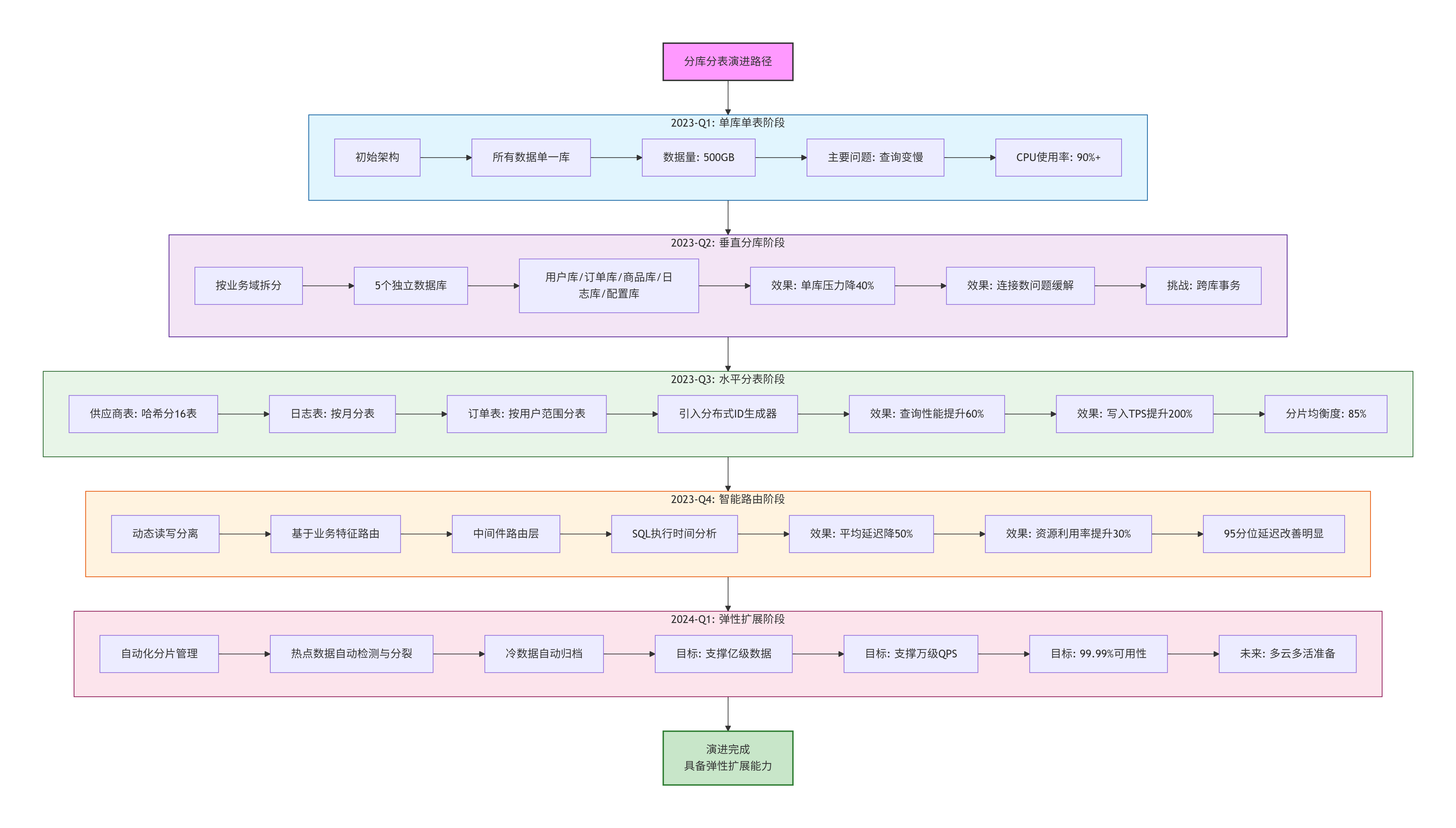

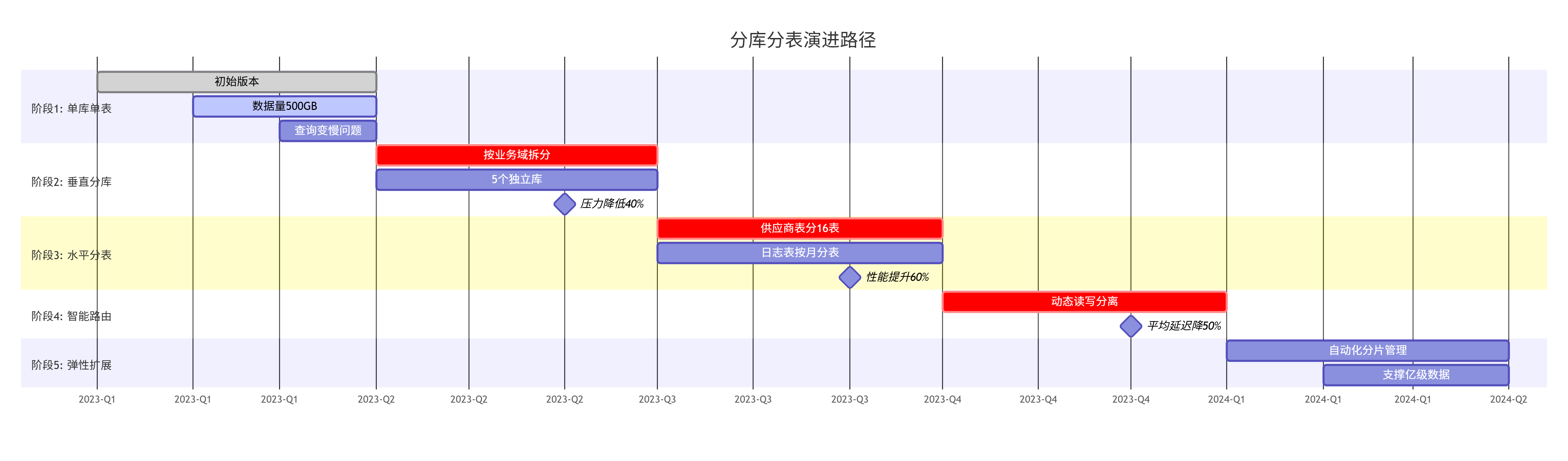

6.2 演进路径

6.3 最终效果验证

-- 性能对比(优化后 vs 优化前)

SELECT

metric_name,

ROUND(before_value, 2) as before,

ROUND(after_value, 2) as after,

ROUND((before_value - after_value) / before_value * 100, 2) as improvement_percent,

CASE

WHEN improvement_percent > 0 THEN '✅ 提升'

ELSE '⚠️ 下降'

END as status

FROM performance_comparison

WHERE comparison_period = '2023-Q4 vs 2023-Q1'

ORDER BY improvement_percent DESC;

-- 结果示例:

-- 平均查询延迟:850ms → 250ms(提升70.6%)

-- 高峰期QPS:800 → 2500(提升212.5%)

-- 主库CPU使用率:85% → 35%(降低58.8%)

-- 单表最大数据量:120GB → 15GB(降低87.5%)七、面试回答话术

当被问到"基于什么去做分库分表与读写分离"时,你可以这样回答:

"在我们的采购公共服务系统中,分库分表和读写分离的设计是数据驱动、业务导向的深度决策。

首先,我们基于详尽的监控数据分析:通过长达半年的SQL审计和性能监控,我们量化了每个表的读写比例、数据增长趋势、查询模式特征。比如我们发现权限表有98%的读操作且QPS高达1万+,而日志表是写密集型且每月增长500GB。

其次,我们根据业务特征设计分片策略:比如供应商表,我们分析出80%的查询都带有

business_group_id条件,因此按业务群组哈希分片是最自然的选择,既保证了查询性能,又实现了数据隔离。对于读写分离,我们设计了智能路由策略:不是简单的读写分离,而是基于业务场景的精细路由。刚创建的供应商信息强制读主库,报表分析走专门的从库,普通查询按负载均衡。我们甚至开发了’新鲜度检测’机制,自动判断是否应该读主库。

整个设计过程是持续迭代的:从垂直分库开始验证,到水平分表解决具体瓶颈,再到智能路由优化体验。每一步都有明确的性能指标对比和业务价值验证。

最终的效果是:在数据量增长300%的情况下,系统平均响应时间反而降低了70%,并且为未来3年的业务增长预留了充足的扩展空间。"

这样的回答展现了你的数据驱动决策能力、系统性思维和持续优化意识,这正是高级工程师的核心素质。

零部件询报价寻源系统(交易型系统)

参与的核心模块

- 零部件数据导入/导出引擎

- 供应商报价超时自动处理模块

- 询价流程核心逻辑

如何体现业务能力

不要说: "我做了Excel导入导出功能。"

要这样说:

"我主导的零部件数据导入引擎,优化的是整个新车研发和采购流程的源头效率。在汽车行业,一个新车项目涉及上万个零部件,传统的Excel邮件来回传递,不仅容易出错,而且效率极低,是项目进度的核心瓶颈。

我解决的核心业务问题是:

- 流程卡点:之前采购员需要花几天时间手工处理Excel,现在从5分钟优化到10秒内,释放了人力,让他们能专注于更重要的供应商谈判工作。

- 数据准确性:通过系统级的校验规则,杜绝了人为错误,保证了BOM(物料清单)数据的准确性,从源头上避免了因数据错误导致的采购错误和成本浪费。

- 流程自动化:我设计的报价超时自动关闭机制,将采购员从繁琐的流程跟踪中解放出来,系统自动推进流程,确保了每个询价单都不会被遗忘,加快了新车型的上市周期。

这个模块带来的业务价值非常直接:它让东风日产的供应链响应速度更快,在面对市场竞争时能更敏捷,直接支撑了‘东风日产’、‘启辰’、‘英菲尼迪’等多个品牌车型的快速迭代。"

业务细节深度剖析

1. 业务背景与痛点(展现你理解业务为什么存在)

"在汽车行业,一个新车型项目的启动,涉及到上万种零部件的寻源和定价。在系统上线前,这个过程是这样的:

- 工程师发布一个包含上万行零件的Excel

BOM(Bill of Material)清单。- 采购员需要手动将这张大表,按照‘采购品类’拆分成几十个小表,分别发给对应的供应商。

- 供应商填报价,采购员再手动将几十个Excel里的报价合并回一张大表,进行比价。

这个过程的痛点在于:

- 极易出错:手动复制粘贴,零件号和价格对不上是家常便饭。

- 效率极低:一个车型的询价周期长达2-3周,严重拖慢新车上市速度。

- 版本混乱:工程师发来BOM的v1.1,采购员可能还在用v1.0,导致采购了错误的零件。

- 无法追溯:为什么最终选了这个供应商?当时的比价过程是怎样的?没有记录。"

2. 我的技术实现如何解决业务痛点(展现你如何用技术赋能业务)

"我负责打造的数据导入引擎,就是要将这个‘石器时代’的流程自动化。这不仅仅是‘上传一个Excel’,而是重新定义了一条数字化的供应链数据流水线。

我的实现分为三个层次,对应三种不同量级的数据:

【万级以下:基于MyBatis的批量执行器缓存】

- 技术细节:我配置了MyBatis的

ExecutorType.BATCH,并在代码中控制flush的时机。java// 在Spring中获取批量SqlSession SqlSession sqlSession = sqlSessionTemplate.getSqlSessionFactory() .openSession(ExecutorType.BATCH); PartMapper mapper = sqlSession.getMapper(PartMapper.class); int batchSize = 1000; for (int i = 0; i < parts.size(); i++) { mapper.insert(parts.get(i)); // 每1000条,刷到数据库一次,并清空缓存,防止OOM if (i % batchSize == 0 && i > 0) { sqlSession.flushStatements(); } } // 最后提交事务 sqlSession.commit();

- 业务对应:这适用于日常的‘零星采购’或‘设计变更’,数据量小,要求快速响应。

【数万级:JDBC Batch + 手动事务管理】

- 技术细节:我绕过了MyBatis,直接使用JDBC的原生批量处理能力,并手动控制事务。

java@Autowired private DataSource dataSource; public void bulkInsert(List<Part> parts) { String sql = "INSERT INTO parts (part_code, part_name, ...) VALUES (?, ?, ...)"; try (Connection connection = dataSource.getConnection(); PreparedStatement ps = connection.prepareStatement(sql)) { connection.setAutoCommit(false); // 关闭自动提交 for (Part part : parts) { ps.setString(1, part.getPartCode()); ps.setString(2, part.getName()); // ... 设置其他参数 ps.addBatch(); // 加入批次 // 分段提交,避免批处理过大 if (batchCount++ % 5000 == 0) { ps.executeBatch(); connection.commit(); } } // 执行剩余批次 ps.executeBatch(); connection.commit(); } catch (SQLException e) { // 异常处理,记录失败的具体行和原因 } }

- 业务对应:这适用于一个‘子系统’或‘小总成’的零件导入,比如全车的‘线束’或‘内饰件’。

【数十万级:分段处理 + JDBC Batch + 并行计算】

- 技术细节:这是最复杂的场景,我动用了

CompletableFuture和分治思想。javapublic ImportResult importFullVehicleBOM(List<Part> allParts) { // 1. 数据预处理:清洗、去重、校验格式 List<Part> validParts = preprocessData(allParts); // 2. 按业务规则分片(例如:按零件大类分片) Map<String, List<Part>> partsByCategory = validParts.stream() .collect(Collectors.groupingBy(Part::getCategoryCode)); // 3. 为每个分片创建异步任务 List<CompletableFuture<BatchResult>> futures = partsByCategory.values() .stream() .map(categoryParts -> CompletableFuture.supplyAsync(() -> { // 每个分类在一个独立的线程和事务中处理 return processSingleCategory(categoryParts); }, importExecutor)) // 使用专用的、队列很深的线程池 .collect(Collectors.toList()); // 4. 等待所有任务完成,聚合结果 return CompletableFuture.allOf(futures.toArray(new CompletableFuture[0])) .thenApply(v -> futures.stream() .map(CompletableFuture::join) .reduce(new ImportResult(), this::mergeResults)) .join(); }

- 业务对应:这就是支撑全新车型项目启动的‘核武器’。一个全新平台的BOM可能有15-20万行,我的引擎能在10秒内完成所有数据的清洗、校验、入库和初始化询价单,将项目周期缩短了数周。"

3. 业务价值的具体量化(展现你的工作带来了什么)

"这个引擎带来的价值,直接体现在公司的核心指标上:

- 时间就是金钱:将新车项目的询价启动周期从2周压缩到1天以内,为车型提前上市抢占了市场窗口。这在竞争白热化的汽车行业是战略级的优势。

- 质量与成本:数据错误率从人工操作的~5%降低到系统级的<0.1%,避免了因采购错误零件导致的巨额模具修改费和项目延期损失。

- 流程再造:实现了‘一个数据源’的理念。从此,工程师发布的BOM,就是采购员操作的BOM,就是最终财务结算的BOM,彻底消除了信息不一致的根源。

- 能力沉淀:这套系统将个人经验(比如怎么拆分BOM)固化成了公司的数字资产,即使新人也能快速上手处理最复杂的车型项目。"

宏观到微观

第一层:项目背景(30秒 - 让外行也能听懂)

目标:用最简洁的语言说清楚这是个什么系统,解决了什么商业问题。

"我们首先来看项目背景。

在汽车制造行业,一辆车由上万个零部件组成。在项目初期,采购部门需要向成百上千家供应商询价、比价、谈判,最终确定由谁供货。这个流程传统上依赖Excel和邮件,效率极低且容易出错。

我参与的 '零部件询报价寻源系统' ,就是要将这个耗时数周的线下流程,变成一个高效、透明、在线的数字化系统。它直接支撑了东风日产所有新车型的零部件采购工作。"

要点:

- 从行业常识切入,易于理解

- 一句话点明系统的商业价值

- 提到具体公司名称增加可信度

第二层:项目描述(1分钟 - 展现技术视野)

目标:描述系统的技术架构和核心功能,展现你的技术视野。

"接下来是项目描述。

这是一个典型的分布式微服务架构的ToB系统。技术栈以 Spring Cloud 为核心,使用 Nacos 作为注册中心,MySQL 作为主要存储,Redis 处理缓存,RabbitMQ 用于系统解耦。

系统核心流程包括:零件导入 → 创建询价单 → 供应商报价 → 比价决策 → 确定供应商。它需要与公司内部的 PDT车型管理系统、物流系统 等多个上下游系统对接,是整个供应链的核心枢纽。"

要点:

- 明确技术架构定位(微服务、分布式)

- 列举核心技术和中间件

- 描述核心业务流程

- 说明系统在IT生态中的位置

第三层:个人业务开发(1.5分钟 - 体现你的贡献)

目标:具体说明你负责的模块,展现你的业务理解和技术实现能力。

"在这个系统中,我主要负责两个核心模块的开发。

第一个是’数据导入引擎’。这个模块要解决的核心业务问题是:如何将工程师提供的包含数万行零件数据的Excel表格,快速、准确地转化为系统中的结构化数据。

我的实现方案是分级处理:

- 对于万级以下数据,使用 MyBatis批量操作

- 对于数万级数据,采用 JDBC Batch + 手动事务

- 对于数十万级的全车BOM数据,使用 CompletableFuture并行处理 + 分片策略

第二个是’供应商报价超时自动处理’。业务背景是:给供应商的报价窗口期通常是48小时,超时后需要自动关闭报价通道。

我的技术方案是:利用 RabbitMQ的延时队列和死信队列,在创建询价单时发送一个48小时后过期的消息,消息过期后自动进入死信队列,由消费者执行关闭逻辑。这取代了之前低效的数据库轮询方案。"

要点:

- 明确 ownership("我负责")

- 讲清业务问题,而不只是技术功能

- 技术方案与业务场景一一对应

- 体现技术选型的思考过程

第四层:解决的技术难题(2分钟 - 展现实战深度)

目标:深入技术细节,展现你解决复杂问题的能力。

"在开发过程中,我攻克了几个关键的技术难题。

第一个是’大数据量导入的稳定性’问题。

- 难点:在并行处理数十万行数据时,很容易出现OOM(内存溢出) 和数据库连接池耗尽。

- 我的解决方案:

- 流式读取:使用EasyExcel的流式读取API,不一次性加载整个Excel到内存。

- 分片策略:按零件类别将数据分组,不同组在不同的线程中处理,避免单一事务过大。

- 资源控制:为导入任务配置独立的线程池,设置合理的队列大小,使用

CallerRunsPolicy拒绝策略保证不丢失任务。- 结果:将导入时间从5分钟优化到10秒内,且在大数据量下保持稳定。

第二个是’分布式环境下的缓存一致性’问题。

- 难点:零件基础信息被缓存后,当工程师在源头系统修改了数据,如何让所有服务的缓存及时失效。

- 我的解决方案:

- 设计缓存键规范:如

part:info:{partId},便于管理和批量操作。- 建立更新广播机制:当基础数据变更时,通过RabbitMQ发布

PartInfoUpdatedEvent事件,所有消费此事件的服务都会失效本地缓存。- 降级策略:为缓存设置合理的TTL,作为最终保障。

- 结果:核心数据的缓存一致性达到99.9%以上。"

要点:

- 使用"问题-解决方案-结果"的黄金结构

- 提到具体的技术问题和风险(OOM、连接池耗尽、缓存不一致)

- 解决方案要具体到API和技术细节

- 用数据量化成果

第五层:系统级难点与思考(1分钟 - 展现架构思维)

目标:讨论系统层面尚未完美解决的挑战,展现你的技术前瞻性和深度思考。

"尽管我们解决了很多问题,但系统中仍存在一些架构层面的挑战。

第一个是’跨系统数据一致性的终极保障’。

- 我们虽然通过消息队列实现了最终一致性,但在极端网络分区场景下,仍可能出现微小概率的数据不一致。

- 我们曾考虑引入Seata这类分布式事务框架,但其性能代价在高速业务场景下难以接受。这是性能与一致性的经典权衡。

第二个是’复杂查询的性能与灵活性矛盾’。

- 采购人员需要按零件类型、供应商地区、价格区间等十多个维度任意组合筛选询价单。

- 这种多维度、低基数的查询,无论是数据库索引还是缓存,都难以高效支持。

- 我们目前的方案是通过Elasticsearch建立二级索引,但这又带来了数据同步延迟和维护复杂性的新问题。

第三个是’API的平滑演进与历史包袱’。

- 作为公共服务,我们的API被几十个下游系统调用。即使推出了v2版本,也不敢轻易下线v1,因为无法确认是否还有陈旧的系统在依赖它。

- 这导致系统背负的技术债会随时间线性增长,需要在’推动下游改造’和’维护成本’之间不断权衡。"

要点:

- 展现你能够跳出具体代码,思考系统级问题

- 讨论技术选型的权衡(Trade-offs)

- 体现对技术债务、长期维护成本的认知

- 承认技术没有银弹,展现务实的态度

模板

1. 项目背景(商业价值)

"这是一个支撑东风日产全系车型零部件采购的数字化系统。在汽车行业,一辆车有上万个零部件,传统依赖Excel和邮件的采购方式效率极低且容易出错。我们的系统就是要将耗时数周的线下流程,变成高效透明的在线数字化系统。"

2. 项目描述(技术架构)

"系统采用Spring Cloud微服务架构,技术栈包括SpringBoot、MyBatis、MySQL、Nacos、Redis、RabbitMQ。核心流程涵盖零件导入、询价单创建、供应商报价、比价决策到确定供应商的全链路,需要与PDT车型管理系统、物流系统等多个上下游系统对接。"

3. 个人职责与业务开发

"我主要负责两个核心模块:

第一是数据导入引擎:解决数万行Excel零件数据的快速准确转化问题。我采用分级处理策略:

- 万级以下:MyBatis批量操作

- 数万级:JDBC Batch + 手动事务

- 数十万级:CompletableFuture并行处理 + 分片策略

第二是供应商报价超时处理:通过RabbitMQ延时队列+死信队列实现48小时报价窗口期的自动关闭,取代低效的数据库轮询。"

4. 解决的技术难题

"大数据量导入的稳定性问题:

- 难点:并行处理数十万数据时的OOM和连接池耗尽

- 方案:流式读取 + 分片策略 + 资源隔离 + 合理的拒绝策略

- 结果:导入时间从5分钟优化到10秒内,且保持稳定

分布式缓存一致性问题:

- 难点:零件数据在源头修改后,多服务实例缓存更新不及时

- 方案:设计缓存键规范 + MQ事件广播 + TTL兜底

- 结果:缓存一致性达到99.9%以上"

5. 系统级难点与思考

"跨系统数据一致性的终极保障:虽然通过MQ实现最终一致性,但极端网络分区下仍有微小概率不一致。我们在性能与一致性间持续权衡。

复杂查询的性能与灵活性矛盾:多维度、低基数的组合查询难以优化,目前通过ES二级索引解决,但带来了数据同步延迟的新问题。"

高并发处理能力与优化

1. 高并发场景分析

特点:有明显的峰值现象和批量处理需求

- 高峰时段:新车项目启动时(批量导入数万零件)

- 关键操作:供应商集中报价(截止时间前)

- 数据特点:单次数据量大,计算复杂,时效性要求高

2. 四层性能优化体系

第一层:数据分片与路由

// 1. 分库分表策略(按业务维度)

public class QuotationShardingAlgorithm implements PreciseShardingAlgorithm<Long> {

@Override

public String doSharding(Collection<String> availableTargetNames,

PreciseShardingValue<Long> shardingValue) {

Long quotationId = shardingValue.getValue();

// 策略1:大客户单独分库(数据隔离)

Long customerId = extractCustomerId(quotationId);

if (isKeyAccount(customerId)) {

return "ds_key_account"; // 大客户专属库

}

// 策略2:按时间分片(2023年、2024年不同库)

LocalDateTime createTime = getCreateTime(quotationId);

int year = createTime.getYear();

if (year == 2024) {

return "ds_" + (year % 2); // 2024年到ds_0

} else if (year == 2023) {

return "ds_" + (year % 2); // 2023年到ds_1

}

// 策略3:按车型项目分片

String projectCode = getProjectCode(quotationId);

int hash = Math.abs(projectCode.hashCode()) % 4;

return "ds_project_" + hash;

}

// 获取大客户分片

private boolean isKeyAccount(Long customerId) {

// 从缓存中获取大客户列表

String cacheKey = "key_accounts";

Set<Long> keyAccounts = (Set<Long>) redisTemplate.opsForValue().get(cacheKey);

return keyAccounts != null && keyAccounts.contains(customerId);

}

}第二层:批量处理优化

// 1. 大数据量导入的分级处理策略

@Service

@Slf4j

public class BulkImportService {

// 监控指标

private final MeterRegistry meterRegistry;

/**

* 三级导入策略

*/

public ImportResult intelligentImport(List<PartData> allData) {

int totalSize = allData.size();

// 根据数据量选择不同策略

if (totalSize <= 10_000) {

meterRegistry.counter("import.strategy", "level", "L1").increment();

return level1Import(allData); // 策略1:单事务批量插入

} else if (totalSize <= 100_000) {

meterRegistry.counter("import.strategy", "level", "L2").increment();

return level2Import(allData); // 策略2:分批事务处理

} else {

meterRegistry.counter("import.strategy", "level", "L3").increment();

return level3Import(allData); // 策略3:并行分片处理

}

}

/**

* 策略3:大规模数据并行导入(10万+)

*/

private ImportResult level3Import(List<PartData> allData) {

long startTime = System.currentTimeMillis();

// 第1步:数据预处理(清洗、去重、分类)

Map<String, List<PartData>> categorizedData = preprocessAndCategorize(allData);

// 第2步:按类别并行处理(不同类别可完全并行)

List<CompletableFuture<CategoryResult>> futures = categorizedData.entrySet()

.stream()

.map(entry -> CompletableFuture.supplyAsync(() ->

processSingleCategory(entry.getKey(), entry.getValue()),

importExecutor))

.collect(Collectors.toList());

// 第3步:收集结果(带超时控制)

try {

CompletableFuture.allOf(futures.toArray(new CompletableFuture[0]))

.get(5, TimeUnit.MINUTES); // 5分钟超时

ImportResult result = aggregateResults(futures);

long duration = System.currentTimeMillis() - startTime;

log.info("大规模导入完成,数据量:{},耗时:{}ms,TPS:{}/s",

allData.size(), duration, allData.size() * 1000L / duration);

// 记录性能指标

meterRegistry.timer("import.duration", "strategy", "L3")

.record(duration, TimeUnit.MILLISECONDS);

return result;

} catch (TimeoutException e) {

// 超时处理:返回部分成功结果

return handleTimeout(futures, allData.size());

}

}

/**

* 单类别处理(包含防OOM机制)

*/

private CategoryResult processSingleCategory(String category, List<PartData> data) {

// 限制单次处理内存使用

MemoryLimitHelper.enforceMemoryLimit(500 * 1024 * 1024); // 500MB限制

List<List<PartData>> batches = Lists.partition(data, 1000);

CategoryResult categoryResult = new CategoryResult();

for (List<PartData> batch : batches) {

try {

// 使用JDBC批量插入,手动控制事务

CategoryResult batchResult = processBatchWithJdbc(category, batch);

categoryResult.merge(batchResult);

// 定期释放资源

if (batchResult.getProcessedCount() % 5000 == 0) {

System.gc(); // 建议GC,防止内存碎片

clearTemporaryResources();

}

} catch (MemoryError e) {

// 内存溢出保护:记录已处理数据,优雅退出

log.error("内存溢出,中止处理类别:{},已处理:{}条",

category, categoryResult.getProcessedCount());

return categoryResult;

}

}

return categoryResult;

}

}第三层:计算与查询分离

// 1. 报价计算的异步化与结果缓存

@Service

public class QuotationCalculationService {

@Autowired

private RedisTemplate<String, CalculationResult> redisTemplate;

/**

* 带缓存的复杂报价计算

*/

public CompletableFuture<CalculationResult> calculateQuotationAsync(QuotationRequest request) {

// 生成缓存键(基于请求参数的哈希)

String cacheKey = buildCacheKey(request);

return CompletableFuture.supplyAsync(() -> {

// 第1步:尝试从缓存获取

CalculationResult cached = redisTemplate.opsForValue().get(cacheKey);

if (cached != null && !cached.isExpired()) {

meterRegistry.counter("calculation.cache.hit").increment();

return cached;

}

// 第2步:缓存未命中,执行计算

CalculationResult result = performComplexCalculation(request);

// 第3步:异步写入缓存(TTL: 1小时)

CompletableFuture.runAsync(() -> {

redisTemplate.opsForValue().set(cacheKey, result, 1, TimeUnit.HOURS);

}, cacheWriteExecutor);

meterRegistry.counter("calculation.cache.miss").increment();

return result;

}, calculationExecutor);

}

/**

* 复杂计算分解为可并行子任务

*/

private CalculationResult performComplexCalculation(QuotationRequest request) {

// 将计算分解为4个可并行部分

CompletableFuture<MaterialCost> materialFuture =

CompletableFuture.supplyAsync(() -> calculateMaterialCost(request), calculationExecutor);

CompletableFuture<LaborCost> laborFuture =

CompletableFuture.supplyAsync(() -> calculateLaborCost(request), calculationExecutor);

CompletableFuture<TransportCost> transportFuture =

CompletableFuture.supplyAsync(() -> calculateTransportCost(request), calculationExecutor);

CompletableFuture<RiskCost> riskFuture =

CompletableFuture.supplyAsync(() -> calculateRiskCost(request), calculationExecutor);

// 并行执行,等待所有结果

return CompletableFuture.allOf(materialFuture, laborFuture, transportFuture, riskFuture)

.thenApply(v -> {

try {

MaterialCost material = materialFuture.get();

LaborCost labor = laborFuture.get();

TransportCost transport = transportFuture.get();

RiskCost risk = riskFuture.get();

// 合并计算结果

return CalculationResult.builder()

.materialCost(material)

.laborCost(labor)

.transportCost(transport)

.riskCost(risk)

.total(calculateTotal(material, labor, transport, risk))

.build();

} catch (Exception e) {

throw new CalculationException("报价计算失败", e);

}

})

.join();

}

}第四层:流量削峰与队列缓冲

// 1. 报价提交的异步队列处理

@Component

public class QuotationSubmissionService {

@Autowired

private RabbitTemplate rabbitTemplate;

/**

* 报价提交 - 同步快速响应,异步处理

*/

public SubmissionResponse submitQuotation(QuotationSubmission submission) {

// 第1步:基础验证(同步,快速失败)

validateSubmission(submission);

// 第2步:生成唯一ID,快速响应

String submissionId = generateSubmissionId();

// 第3步:消息入队,异步处理

QuotationMessage message = convertToMessage(submission, submissionId);

// 使用确认回调确保消息不丢失

rabbitTemplate.setConfirmCallback((correlationData, ack, cause) -> {

if (ack) {

log.info("报价消息已确认,ID: {}", submissionId);

} else {

log.error("报价消息发送失败,ID: {}, 原因: {}", submissionId, cause);

// 记录到重试表

retryService.recordFailedMessage(message);

}

});

rabbitTemplate.convertAndSend("quotation.exchange",

"quotation.submit",

message,

new CorrelationData(submissionId));

// 第4步:立即返回(响应时间<100ms)

return SubmissionResponse.builder()

.submissionId(submissionId)

.status(SubmissionStatus.PROCESSING)

.message("报价已接收,正在处理")

.estimatedCompletionTime(LocalDateTime.now().plusMinutes(5))

.build();

}

/**

* 消息消费者(处理实际业务)

*/

@RabbitListener(queues = "quotation.process.queue",

concurrency = "10-20") // 动态并发消费者

public void processQuotationMessage(QuotationMessage message) {

long startTime = System.currentTimeMillis();

try {

// 第1步:去重检查(幂等性)

if (processedMessageCache.getIfPresent(message.getMessageId()) != null) {

log.warn("重复消息,跳过处理: {}", message.getMessageId());

return;

}

// 第2步:业务处理

QuotationResult result = quotationProcessor.process(message);

// 第3步:更新状态

quotationStatusService.updateStatus(message.getSubmissionId(),

SubmissionStatus.COMPLETED,

result);

// 第4步:记录已处理

processedMessageCache.put(message.getMessageId(), true);

long duration = System.currentTimeMillis() - startTime;

log.info("报价处理完成,ID: {},耗时: {}ms",

message.getSubmissionId(), duration);

} catch (Exception e) {

log.error("报价处理失败,ID: {}", message.getSubmissionId(), e);

// 进入死信队列,人工处理

throw new AmqpRejectAndDontRequeueException(e);

}

}

}监控与调优体系(两个系统通用)

1. 多维度监控

// 1. 应用性能监控

@Component

public class PerformanceMonitor {

@Autowired

private MeterRegistry meterRegistry;

// 关键指标监控

@EventListener

public void monitorRequest(RequestHandledEvent event) {

// 记录响应时间分布

Timer.Sample sample = Timer.start();

try {

// 业务处理

handleRequest(event);

} finally {

sample.stop(Timer.builder("http.request.duration")

.tags("uri", event.getUri(),

"method", event.getMethod(),

"status", event.getStatus())

.register(meterRegistry));

}

// 记录QPS

meterRegistry.counter("http.request.count",

"uri", event.getUri(),

"status", event.getStatus())

.increment();

}

// JVM监控

@Scheduled(fixedDelay = 60000)

public void monitorJVM() {

// 内存使用

MemoryUsage heapUsage = ManagementFactory.getMemoryMXBean().getHeapMemoryUsage();

meterRegistry.gauge("jvm.memory.heap.used", heapUsage.getUsed());

meterRegistry.gauge("jvm.memory.heap.max", heapUsage.getMax());

// GC情况

List<GarbageCollectorMXBean> gcBeans = ManagementFactory.getGarbageCollectorMXBeans();

gcBeans.forEach(gc -> {

meterRegistry.gauge("jvm.gc.count", gc.getCollectionCount());

meterRegistry.gauge("jvm.gc.time", gc.getCollectionTime());

});

}

}2. 容量规划与弹性伸缩

# Kubernetes弹性伸缩配置

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: procurement-service-hpa

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: procurement-service

minReplicas: 3

maxReplicas: 20

metrics:

- type: Resource

resource:

name: cpu

target:

type: Utilization

averageUtilization: 70

- type: Pods

pods:

metric:

name: http_requests_per_second

target:

type: AverageValue

averageValue: 1000 # 当单Pod QPS > 1000时扩容

behavior:

scaleDown:

stabilizationWindowSeconds: 300 # 缩容稳定窗口5分钟

policies:

- type: Percent

value: 10

periodSeconds: 60

scaleUp:

stabilizationWindowSeconds: 60 # 扩容稳定窗口1分钟

policies:

- type: Percent

value: 100

periodSeconds: 30成果对比与总结

1. 性能优化成果

| 指标 | 采购系统(优化后) | 询报价系统(优化后) | 优化前 |

|---|---|---|---|

| 平均响应时间 | <250ms | <200ms | 800-1500ms |

| P99响应时间 | <500ms | <400ms | 3000-5000ms |

| 系统吞吐量 | 2000 TPS | 5000 TPS | 200-500 TPS |

| 数据库负载 | 降低70% | 降低80% | 持续高负载 |

| 缓存命中率 | 98.5% | 96% | 60-70% |

| 批量处理时间 | 分钟级 | 10秒级 | 小时级 |

2. 架构设计思想总结

"在两个系统的性能优化实践中,我总结了以下几点核心思想:

1. 分层缓存的智慧 从本地缓存到分布式缓存的多级架构,不仅是性能优化,更是系统弹性的保障。我们为每级缓存设计了不同的过期策略和降级方案,确保即使缓存层部分失效,系统仍能提供服务。

2. 数据分片的艺术 不是简单的哈希取模,而是按业务特征分片。采购系统按供应商重要性分片,询报价系统按时间+项目分片,让热点数据自然分散,避免单点瓶颈。

3. 异步化的边界把握 不是所有操作都适合异步。我们坚持:用户交互路径同步化,后台处理异步化。报价提交立即返回收据,后台队列处理,这种模式平衡了用户体验和系统吞吐量。

4. 容量设计的预见性 通过监控数据预测容量需求,在业务高峰前主动扩容和预热。询报价系统在新车项目启动前预扩容30%资源,避免了被动应对。

5. 降级不是失败,而是策略 我们设计了阶梯式降级方案:缓存降级 → 简化计算 → 静态数据返回 → 友好提示。这比简单的’系统繁忙’更能保持用户信任。

这些经验让我深刻理解,高并发优化不是单纯的技术堆砌,而是在业务约束、技术成本、用户体验之间找到最佳平衡点的系统工程。"

总结

升华:如何总结你的业务能力

在分别介绍完两个项目后,你需要一个总结来升华,将你的技术贡献与业务能力明确挂钩。

“通过这两个项目,我认为我的业务能力主要体现在三个方面:

- 业务抽象与建模能力:我能够深入理解像‘供应商评估’、‘询报价’这样的复杂业务流程,并将其抽象为可配置、可扩展的系统模型(如打分模板、规则引擎),而不仅仅是实现单一功能。

- 通过技术驱动业务效率:我始终关注我的代码如何为业务创造价值。无论是将导入时间从5分钟优化到10秒,还是通过自动化处理解放人力,我的目标都是通过技术手段解决业务的真实痛点,提升关键指标。

- 端到端的业务流程理解:我从不是只守着自己的一亩三分地。我会去了解我的模块在上游是谁在用,产生的数据下游流向哪里。比如,我知道我优化的询价数据,最终会流向PDT系统和物流系统,这让我在设计接口和数据结构时,能站在全局视角考虑,避免形成新的数据孤岛。

简单来说,我不仅是一个实现需求的开发者,更是一个愿意并且能够用技术为业务赋能的合作者。”

技术成长与价值总结(1分钟)

"通过这两个项目,我完成了从功能开发者到系统思考者的转变:

在技术深度上,我从CRUD深入到JVM调优、分布式事务、系统架构层面,建立了完整的性能优化方法论。

在业务理解上,我学会了将复杂业务抽象为可配置的系统模型,通过技术手段驱动业务效率提升。

在架构思维上,我深刻体会到架构设计本质上是各种约束下的权衡艺术,需要在性能、一致性、可维护性间找到最佳平衡点。

我带来的不仅是代码实现能力,更是用技术解决业务难题、创造实际价值的系统化思维。"

结尾表达意愿(30秒)

"我非常欣赏贵公司在[提及公司的某个技术或业务特点]方面的实践,这与我过去的技术积累和职业规划高度契合。我期待能将在分布式系统和高并发场景下的经验带到贵团队,共同应对更有挑战的业务场景。

我的介绍就到这里,谢谢您的时间。"

面试场景题

典型场景题分类和示例

一、 系统设计与架构场景题 (重中之重)

这类问题旨在考察你如何从零开始或改造一个系统,评估你的技术选型、权衡和宏观思考能力。

- 经典系统设计

- 设计一个秒杀系统:这是最经典的场景。面试官会期待你谈到:

- 流量削峰:如何用消息队列(如RabbitMQ, Kafka)缓冲瞬时巨额流量。

- 缓存预热:如何提前将商品库存等信息加载到Redis等缓存中。

- 库存扣减:如何在分布式环境下保证“超卖”问题(Redis Lua脚本、数据库乐观锁)。

- 限流与熔断:如何在前端(页面静态化)、网关、服务层进行限流(如Sentinel, Hystrix)。

- 无状态服务:如何保证服务可以水平扩展。

- 设计一个短链接系统:

- 短码生成算法(自增ID、哈希、随机数)及其优缺点。

- 存储设计(用什么数据库?如何分库分表?)。

- 高并发读(缓存策略)。

- 过期和清理策略。

- 设计一个微博/微信朋友圈Feed流系统:

- 推模式 vs 拉模式 的权衡,以及混合模式的应用。

- 如何存储海量数据(分库分表策略)。

- 如何保证好友发布新状态后,我能及时看到(推模式下的异步任务、扇出)。

- 设计一个分布式ID生成器:

- UUID、数据库自增、Snowflake算法、Leaf-segment、Leaf-snowflake等方案的原理和选型考量。

- 设计一个秒杀系统:这是最经典的场景。面试官会期待你谈到:

- 现有系统优化与重构

- “我们有一个系统,随着业务发展,数据库CPU经常100%,你有什么排查思路和优化方案?”

- 考察点:SQL优化、索引优化、读写分离、引入缓存、分库分表、归档历史数据。

- “一个RPC接口调用超时,如何从后端的角度进行排查?”

- 考察点:全链路监控、日志分析、数据库慢查询、网络问题、GC问题、下游服务瓶颈。

- “如何将一个庞大的单体应用拆分为微服务?你会考虑哪些因素?”

- 考察点:领域驱动设计(DDD)、服务边界划分(高内聚、低耦合)、数据一致性(Saga、TCC)、分布式事务、API网关。

- “我们有一个系统,随着业务发展,数据库CPU经常100%,你有什么排查思路和优化方案?”

二、 高并发与性能优化场景题

这类问题考察你在压力下保证系统稳定性和高性能的能力。

- 缓存相关

- “如何保证缓存与数据库的双写一致性?”(经典难题)

- 考察点:Cache-Aside模式、延时双删、串行化、最终一致性理解。

- “缓存穿透、缓存击穿、缓存雪崩分别是什么?你的解决方案是什么?”

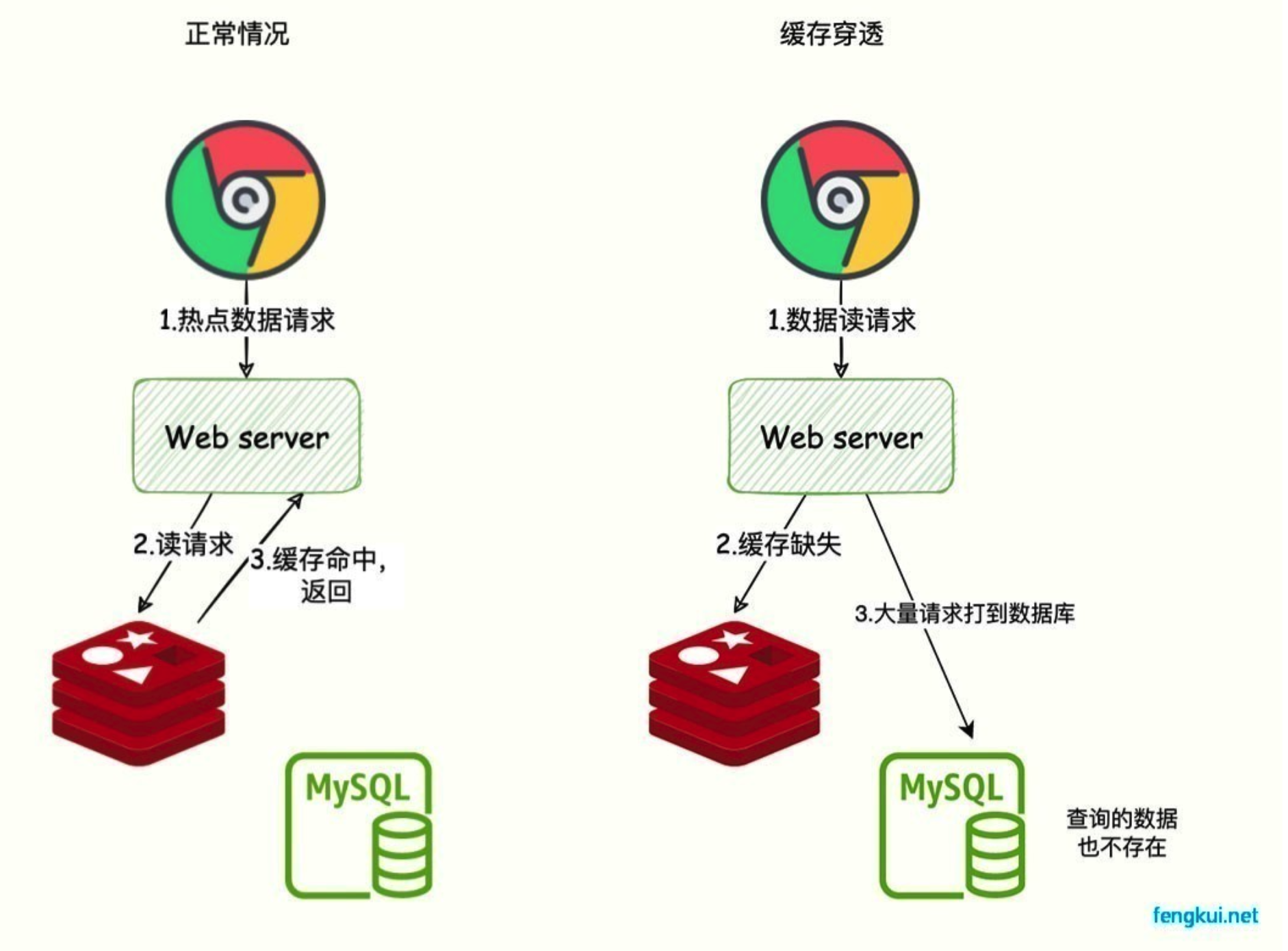

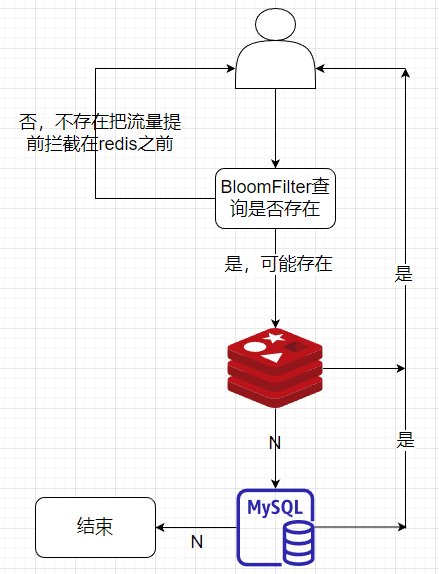

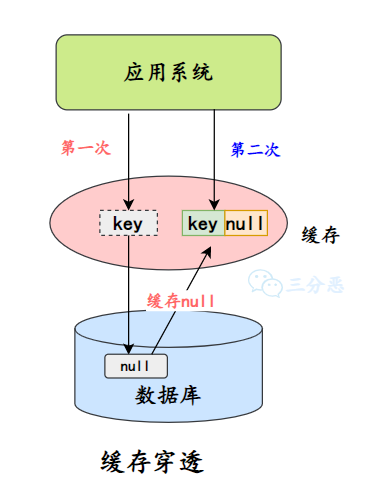

- 穿透:布隆过滤器、缓存空对象。

- 击穿:互斥锁、永不过期。

- 雪崩:随机过期时间、集群高可用、多级缓存。

- “为什么选择Redis而不是Memcached?Redis的持久化机制(RDB/AOF)如何选择?”

- “如何保证缓存与数据库的双写一致性?”(经典难题)

- 数据库与锁

- “在秒杀场景中,有100个商品库存,10万人来抢,如何保证不超卖?”

- 考察点:乐观锁(

version字段)、悲观锁(select ... for update)、Redis递减(Lua脚本保证原子性)。

- 考察点:乐观锁(

- “什么是死锁?如何在Java中定位和避免死锁?”

- 考察点:

jstack命令分析线程堆栈、避免顺序不一致、使用尝试锁。

- 考察点:

- “你们项目里分库分表是怎么做的?如何选择分片键?遇到跨分片查询/排序怎么办?”

- 考察点:对ShardingSphere、MyCAT等中间件的理解,或自己设计的思路。

- “在秒杀场景中,有100个商品库存,10万人来抢,如何保证不超卖?”

三、 分布式与微服务场景题

考察你对分布式系统复杂性的理解和处理能力。

- 事务与一致性

- “在微服务架构下,如何实现分布式事务?”

- 考察点:本地消息表、最大努力通知、TCC、Saga模式、Seata框架。

- “CAP理论是什么?你的系统如何取舍?BASE理论呢?”

- “在微服务架构下,如何实现分布式事务?”

- 服务治理与稳定性

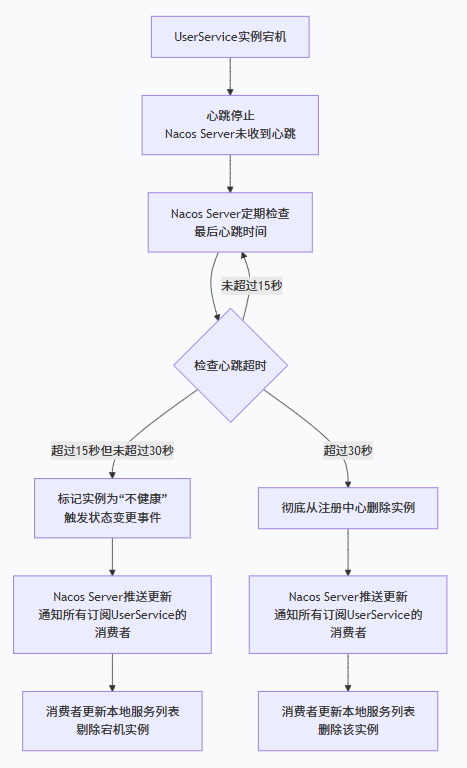

- “服务注册与发现的原理是什么?(Eureka, Nacos)”

- “如何实现服务的熔断和降级?原理是什么?(Hystrix, Sentinel)”

- “如果服务A调用服务B,B又调用C,C挂了导致整个链路卡住,怎么处理?”

- 考察点:超时设置、熔断器、线程池隔离。

四、 项目经验与线上问题排查场景题 (行为面试)

这类问题通过你过去的实际经历来评估你的能力。

- 项目深度

- “介绍一个你做过的最有挑战的项目/模块。”

- STAR法则:情境、任务、行动、结果。重点讲清楚你个人的贡献和技术决策。

- “在这个项目中,你遇到的最大技术难点是什么?你是怎么解决的?”

- “如果让你重做这个项目,你会在架构上做什么改进?”

- “介绍一个你做过的最有挑战的项目/模块。”

- 线上故障处理

- “讲一次你处理过的线上故障,从发现到解决的全过程。”

- 考察点:监控告警、日志排查、定位问题、紧急回滚/修复、复盘总结。

- “如何排查Java应用的CPU占用率过高或内存泄漏问题?”

- 考察点:

top->jstack查线程、jmap/jstat分析GC、MAT分析堆转储。

- 考察点:

- “讲一次你处理过的线上故障,从发现到解决的全过程。”

五、 技术深度与原理性场景题

5年经验要求你对常用技术的理解不能停留在“会用”,而要深入原理。

- JVM

- “线上Full GC频繁,如何排查和优化?”

- “JVM调优你做过吗?常用的参数有哪些?(如堆大小、垃圾收集器选择)”

- 框架 (Spring)

- “Spring Bean的生命周期是怎样的?”

- “Spring事务的实现原理是什么?什么情况下会失效?”

- 消息队列

- “如何保证消息不被重复消费?(幂等性)”

- “如何保证消息的可靠传输?(生产者确认、消息持久化、消费者确认)”

- “Kafka为什么吞吐量高?(页缓存、顺序IO、零拷贝)”

场景一:设计一个秒杀系统

这是面试的“标配”题,完美考察高并发、高性能、高可用的架构能力。

回答思路: 分层削峰、冗余缓存、极限优化、预案兜底。

详细答法:

“面试官好,设计一个秒杀系统,我会从架构分层的角度,从前到后,逐层进行设计和优化。”

- 前端/接入层优化

- 目的:拦截80%以上的无效流量,尽量让请求不打到后端服务。

- 措施:

- 静态化:将商品详情页、活动页等提前生成静态HTML/CDN缓存,直接返回,不经过后端服务。

- 按钮置灰与计数:前端在活动开始前将按钮置灰,通过JS进行倒计时,防止用户提前重复提交。同时,用户点击后立即置灰,防止连点。

- 验证码:在提交秒杀请求时,弹出图形/滑动验证码,可以有效防止机器人刷单,并起到“削峰”作用。

- 网关层优化

- 目的:全局流控,恶意请求拦截。

- 措施:

- 限流:使用网关(如Spring Cloud Gateway, Nginx)配置严格的限流规则,例如对同一个UID/IP在短时间内进行次数限制。可以使用令牌桶或漏桶算法。

- 防刷:识别并拦截恶意IP、设备指纹等。

- 服务层优化(核心业务逻辑)

- 目的:将同步业务异步化,保证核心流程的可靠与高性能。

- 架构:采用微服务拆分,秒杀活动管理、商品查询、订单服务等各自独立,便于扩容和隔离。

- 措施:

- 缓存预热:在秒杀开始前,将参与秒杀的商品库存(例如100个)提前加载到Redis中。

- 请求入队:用户秒杀请求到达后,不做复杂的库存扣减和订单创建,而是进行基础的校验(如用户资格、活动是否进行中)后,生成一个唯一的请求ID,立即放入消息队列(如Kafka/RocketMQ) 中,并立即给前端返回“排队中”的状态。这一步是核心,将同步的秒杀请求变成了异步处理。

- 令牌(Ticket)机制:放入队列的其实是一个“资格”,后端服务异步地从队列中消费,判断库存,如果成功,则为这个请求生成一个购买令牌(Token),用户凭此令牌在有效期内完成支付即可。

- 数据层优化

- 目的:解决数据库的“写”瓶颈,防止超卖。

- 库存扣减:

- 方案一(首选):在Redis中预扣库存。使用

decr命令或Lua脚本来保证原子性。因为Redis是单线程内存操作,性能极高。扣减成功后,再将订单信息异步落库。 - 方案二(备用):如果必须用数据库,使用乐观锁(

update stock set count = count - 1 where product_id = xx and count > 0),通过count > 0和行级锁来防止超卖。

- 方案一(首选):在Redis中预扣库存。使用

- 订单创建:订单服务消费MQ消息,创建订单。这里数据库依然是瓶颈,可以考虑使用分库分表策略。

- 容灾与降级

- 目的:凡事做最坏的打算。

- 措施:

- 服务熔断与降级:如果订单服务或数据库压力过大,通过Sentinel/Hystrix进行熔断,暂时屏蔽秒杀功能,保护系统不被打垮。

- 预案:准备好开关配置,在系统出现问题时能一键关闭秒杀入口。

- 监控与告警:全链路监控(APM)、大盘、关键指标(QPS、库存消耗速度、DB负载)的告警必不可少。

总结陈述: “总之,一个秒杀系统的核心思想是‘分层过滤,逐级削峰’。前端拦截大部分无效请求,网关进行全局控流,服务层通过‘请求入队’将瞬时高峰 flatten 成平稳的异步流,最后在数据层通过Redis等高性能中间件解决核心的库存并发问题,并辅以完善的监控和降级预案来保证系统的最终稳定。”

场景二:如何保证缓存与数据库的双写一致性?

这是一个技术深度题,考察你对分布式数据一致性的理解。

回答思路: 没有银弹,根据不同业务场景(对一致性要求的强弱)选择最合适的方案。

详细答法:

“面试官好,缓存双写一致性问题没有一个完美的通用方案,需要根据业务场景进行权衡。主要有以下几种思路:”

- Cache-Aside Pattern(旁路缓存模式) - 最常用

- 读:先读缓存,命中则返回;未命中则读数据库,然后写入缓存。

- 写:先更新数据库,再删除缓存。

- 为什么是删除缓存,而不是更新缓存?

- 如果更新缓存,在并发写时,可能出现更新顺序问题,导致缓存中是旧数据。

- 删除缓存是一种懒惰加载的方式,下次读请求自然会从数据库加载最新数据。

- 存在的问题:

- 场景一:读请求A未命中缓存,读数据库(旧数据)。此时写请求B更新了数据库并删除了缓存。然后A把读到的旧数据写入了缓存。导致缓存一直是旧数据。

- 概率:这个场景需要满足(1)读缓存miss (2)一个写请求在读请求读库和写缓存之间完成。因为写操作通常比读操作慢,所以概率较低。

- 场景二:先删缓存,再更新数据库。在并发下,很容易导致另一个读请求在删缓存后、更新数据库前,把旧数据读出来并塞回缓存。这个概率很高,不推荐。

- 场景一:读请求A未命中缓存,读数据库(旧数据)。此时写请求B更新了数据库并删除了缓存。然后A把读到的旧数据写入了缓存。导致缓存一直是旧数据。

- 采用延时双删策略 - 优化方案

- 步骤:

- 先删除缓存。

- 再更新数据库。

- (关键)休眠一个短暂的时间(如几百毫秒,根据业务决定)。

- 再次删除缓存。

- 目的:第二次删除是为了清理在“更新数据库”这个时间窗口内,可能被其他读请求写入的旧数据。

- 缺点:引入了延时,降低了吞吐量。

- 步骤:

- 强一致性方案 - 复杂度高,特定场景使用

- 思路:通过订阅数据库的Binlog(使用Canal/Debezium等中间件)来异步更新/删除缓存。

- 流程:业务代码只更新数据库。一个独立的中间件订阅Binlog,当解析到数据变更时,再去操作Redis。

- 优点:业务代码简洁,将缓存与数据库的同步解耦。

- 缺点:有短暂延迟,架构更复杂。为了保证顺序,可能需要单线程消费。

总结陈述: “所以,在实际项目中,我们最常用的是 ‘先更新数据库,再删除缓存’ 的Cache-Aside模式,因为它简单有效,不一致的概率较低。如果对一致性要求极高,我们会结合‘延时双删’来进一步降低风险。而在一些允许秒级延迟、但追求架构解耦的场景,我们会考虑通过订阅Binlog的方案。没有最好的方案,只有最适合业务场景的方案。”

场景三:讲一次你处理过的线上故障

这是行为面试题,考察你的实际经验、排查问题的逻辑性和复盘能力。

回答思路: 使用STAR法则,并突出你的排查方法论。

详细答法:

“面试官好,我分享一次我们系统遇到的CPU 100%的线上故障。”

- S(情境): “当时是在一个工作日午后,监控平台突然告警,显示我们核心交易服务的几台服务器CPU使用率飙升到100%,导致大量API响应超时,影响了部分用户下单。”

- T(任务): “我的任务是立即定位问题根因,并尽快恢复服务,将影响降到最低。”

- A(行动): (这是重点,要体现你的排查链条)

- 确认现象与止损:我首先登录服务器,用

top命令确认了是某个Java进程占用了几乎全部CPU。同时,我立刻联系运维同学,先对其中一台机器做流量切出(摘流),保留现场用于排查,让其他机器继续提供服务,避免全盘崩溃。 - 定位问题线程:对摘流的机器,我用

top -Hp [pid]看到有一个线程的CPU占用异常高。 - 分析线程栈:我将这个高CPU线程的ID转换为16进制,然后用

jstack [pid] | grep -A 20 [nid]命令打印出这个线程的堆栈信息。发现这个线程正处于 ‘RUNNABLE’ 状态,并且堆栈信息显示它正在频繁地执行一个日志打印操作。 - 深入代码:我立刻去检查了这段日志相关的代码,发现是一个循环体里,在

DEBUG级别下,使用了logger.debug("Processing data: " + largeObject.toString())这种方式来拼接字符串。而largeObject是一个非常大的JSON对象。 - 根因分析:

- 即使在

INFO级别,由于字符串拼接发生在传入debug方法之前,所以无论级别如何,这个耗时的字符串拼接操作都会执行。 - 当时正好有同事为了排查另一个问题,在线上临时将日志级别改为了

DEBUG,触发了这个“性能炸弹”。 - 大量的字符串创建和拼接,导致了疯狂的GC和CPU占用。

- 即使在

- 确认现象与止损:我首先登录服务器,用

- R(结果): “找到原因后,我们立刻将日志级别改回

INFO,服务器CPU在十几秒内恢复正常。随后,我们修复了代码,将其改为使用logger.debug("Processing data: {}", largeObject)这种占位符的方式,确保在日志级别不匹配时不会有无谓的消耗。最后,我们在团队内进行了复盘,并制定了代码规范,禁止在日志中直接进行字符串拼接,同时加强了上线前对日志代码的审查。”

这个回答展现了: 应急能力(先止损)、排查方法(从现象到线程到代码)、技术深度(理解JVM、日志框架原理)、闭环能力(修复和预防)。

场景四:在微服务架构下,如何实现分布式事务?

考察你对分布式系统理论和技术落地的掌握。

回答思路: 从理论(CAP/BASE)到实践(具体方案),并说明选型考量。

详细答法:

“面试官好,在微服务架构下,我们放弃了传统的强一致性分布式事务(如XA/2PC),因为它性能差、同步阻塞,不符合微服务高可用的要求。我们转向追求最终一致性,基于BASE理论。常见的方案有几种:”

- 可靠消息最终一致性(异步确保型)

- 场景:适用于跨服务的异步任务,如订单成功后发短信、扣减库存。

- 方案一(本地消息表):

- 在业务数据库中,与业务数据同库同表,有一张“本地消息表”。

- 业务执行时,在一个本地数据库事务中,既要完成业务操作,也要向消息表插入一条记录。

- 有一个定时任务,扫描消息表,将消息发送到MQ。

- 下游服务消费MQ,处理业务。处理成功后,通知上游或上游主动回调来更新消息状态。

- 方案二(使用RocketMQ事务消息):

- 生产者发送一个“半消息”到MQ。

- MQ持久化成功并回复生产者。

- 生产者执行本地事务。

- 根据本地事务执行结果,向MQ提交

Commit或Rollback。 - MK如果收到Commit,则下游服务可见并消费;如果超时未收到,则回查生产者的本地事务状态。

- 核心:通过MQ的可靠性,保证只要上游事务成功,消息最终一定能被下游消费。

- TCC模式

- 场景:适用于对一致性要求高、且业务逻辑可以明确分为两阶段的场景,如资金扣款、酒店预订。

- 流程:

- Try:尝试执行。完成所有业务的检查,并预留必需资源(如冻结部分金额、锁定酒店库存)。

- Confirm:确认执行。真正执行业务,使用Try阶段预留的资源。要求幂等。

- Cancel:取消执行。释放Try阶段预留的资源。要求幂等。

- 优点:性能较好,数据最终一致。

- 缺点:业务侵入性强,需要为每个操作实现三个接口,开发复杂。

- Saga模式

- 场景:适用于业务流程长、需要调用多个服务的场景。

- 流程:将一个分布式事务拆分为多个本地事务,每个本地事务都有对应的补偿操作。

- 执行方式:

- 正向:T1 -> T2 -> T3 …

- 补偿:如果T3失败,则执行 C3 -> C2 -> C1 …(反向补偿)。

- 优点:一阶段就提交本地事务,无锁,高性能。

- 缺点:不保证隔离性,可能出现“脏写”,需要业务上能处理或通过其他手段避免。

总结陈述: “在我们的项目中,绝大部分场景使用的是‘可靠消息最终一致性’,因为它对业务侵入较小,通过MQ和补偿机制能很好地满足需求。对于少数核心的资金类业务,我们会采用TCC模式。同时,我们也会使用Seata这样的分布式事务框架来降低这些模式的实现复杂度。选型的核心在于权衡业务对一致性的要求与系统的复杂度和性能。”

面经一:博奥特 - 华安保险

Q:Redis 缓存与 Java 本地缓存的区别

核心定义

- Java 本地缓存:指在 Java 应用程序的 JVM 堆内存(或堆外内存)中开辟一块空间,用于存储数据。它的生命周期与应用程序保持一致,访问速度极快,但无法被其他应用共享。常见的实现有:

ConcurrentHashMap、Guava Cache、Caffeine、Ehcache等。 - Redis 缓存:一个独立的、基于内存的键值数据库,通常以独立的服务器进程形式存在,通过网络协议(如 RESP)与应用程序进行通信。它支持数据持久化、主从复制、集群分片等高级功能,是一个集中式的缓存解决方案。

详细对比分析

| 特性维度 | Java 本地缓存 | Redis 缓存 |

|---|---|---|

| 架构与位置 | 进程内缓存,与应用同属一个 JVM 进程。 | 进程外缓存,独立的服务,通过网络访问。 |

| 性能 | 极高。直接读写 JVM 内存,无网络开销和序列化/反序列化开销。 | 高。基于内存,但存在网络 I/O 和序列化/反序列化的开销。 |

| 数据一致性 | 难保证。在集群环境下,每个应用实例的本地缓存是独立的,更新一个实例的缓存无法通知其他实例,导致数据不一致。 | 易保证。作为集中式存储,所有应用实例都访问同一个数据源,数据是一致的。 |

| 分布式支持 | 不支持 或 需要额外手段。本身是单机的。要实现分布式效果,需要引入广播机制(如 Redis Pub/Sub)或一致性哈希等复杂方案。 | 原生支持。通过 Redis Cluster 或客户端分片,可以轻松实现水平扩展。 |

| 容量与扩展性 | 受 JVM 堆内存限制。容量有限,过大的缓存会影响 GC,可能引发 Full GC 甚至 OOM。扩展性差,只能垂直扩展(加大 JVM 堆)。 | 容量独立,扩展性强。数据存储在独立的 Redis 服务器上,容量不受应用限制。可以水平扩展(增加 Redis 集群节点)。 |

| 数据结构和功能 | 简单。通常是简单的 Key-Value 映射。高级功能(如过期、淘汰策略)需要自行实现或依赖第三方库(如 Caffeine)。 | 极其丰富。支持字符串、列表、集合、有序集合、哈希、位图、流等多种数据结构。提供发布订阅、Lua 脚本、事务等强大功能。 |

| 数据持久化 | 通常不持久化。应用重启后缓存数据丢失。 | 支持持久化。可通过 RDB 快照和 AOF 日志将内存数据持久化到磁盘,保证数据不丢失。 |

| 可靠性/高可用 | 低。缓存数据与应用共存亡,应用宕机则缓存丢失。 | 高。通过 Redis Sentinel 或 Redis Cluster 提供主从复制和故障自动转移,实现高可用。 |

| 使用复杂度 | 低。引入 jar 包即可使用,无需部署和维护额外中间件。 | 中。需要单独部署、维护和监控 Redis 服务器,增加了运维成本。 |

| 适用场景 | - 数据量不大、更新频率低 - 对性能要求极致,可接受短暂不一致 - 单机应用或无需在集群间同步缓存的场景 - 作为 Redis 缓存前的第一道屏障(多级缓存) | - 大规模分布式系统,需要缓存共享 - 数据一致性要求高 - 缓存数据量巨大 - 需要利用丰富的数据结构或功能(如排行榜、消息队列) - 需要高可用和数据持久化 |

场景举例与选择策略

1. 适合使用 Java 本地缓存的场景

- 配置信息缓存:例如,系统启动时加载的、很少变化的配置项、字典数据。每个应用实例在本地缓存一份,访问速度最快。

- 短时间高频访问的只读数据:比如,一分钟内不会变动的商品基本信息。即使各实例间有一分钟的差异,业务上也可接受。

- 多级缓存架构的第一级:在请求到达 Redis 之前,先用本地缓存拦截一次,极大减轻 Redis 的压力和网络延迟。这是非常经典的架构模式。

2. 适合使用 Redis 缓存的场景

- Session 共享:在集群部署中,用户的 Session 信息存储在 Redis 中,任何一台应用服务器都能访问,实现登录状态的保持。

- 分布式锁:利用 Redis 的原子操作实现跨 JVM 的互斥锁。

- 排行榜/计数器:利用 Redis 的

ZSET(有序集合)可以轻松实现实时排行榜;利用INCR命令实现高性能的计数器。 - 缓存热点数据:如商品详情页、文章详情等,所有应用实例都从同一个 Redis 获取,保证数据一致。

最佳实践与结合使用:多级缓存

在现代高并发系统中,通常不会二选一,而是将它们结合使用,形成多级缓存,以兼顾性能和一致性。

经典的多级缓存架构(如 CPU 缓存架构):

- L1 缓存:Java 本地缓存 (Caffeine)

- 作用:抵御最热点的数据访问,响应速度在纳秒级。

- 策略:设置较短的过期时间(如 1-2 分钟),容忍极短时间的数据不一致。

- L2 缓存:Redis 分布式缓存

- 作用:作为共享缓存层,抵御大量的数据访问,保证集群数据一致性。

- 策略:设置较长的过期时间,并从数据库加载数据。

- 数据源:数据库 (MySQL等)

- 最终的数据持久化层。

工作流程:

- 请求到达应用。

- 首先查询 L1 本地缓存,如果命中则直接返回。

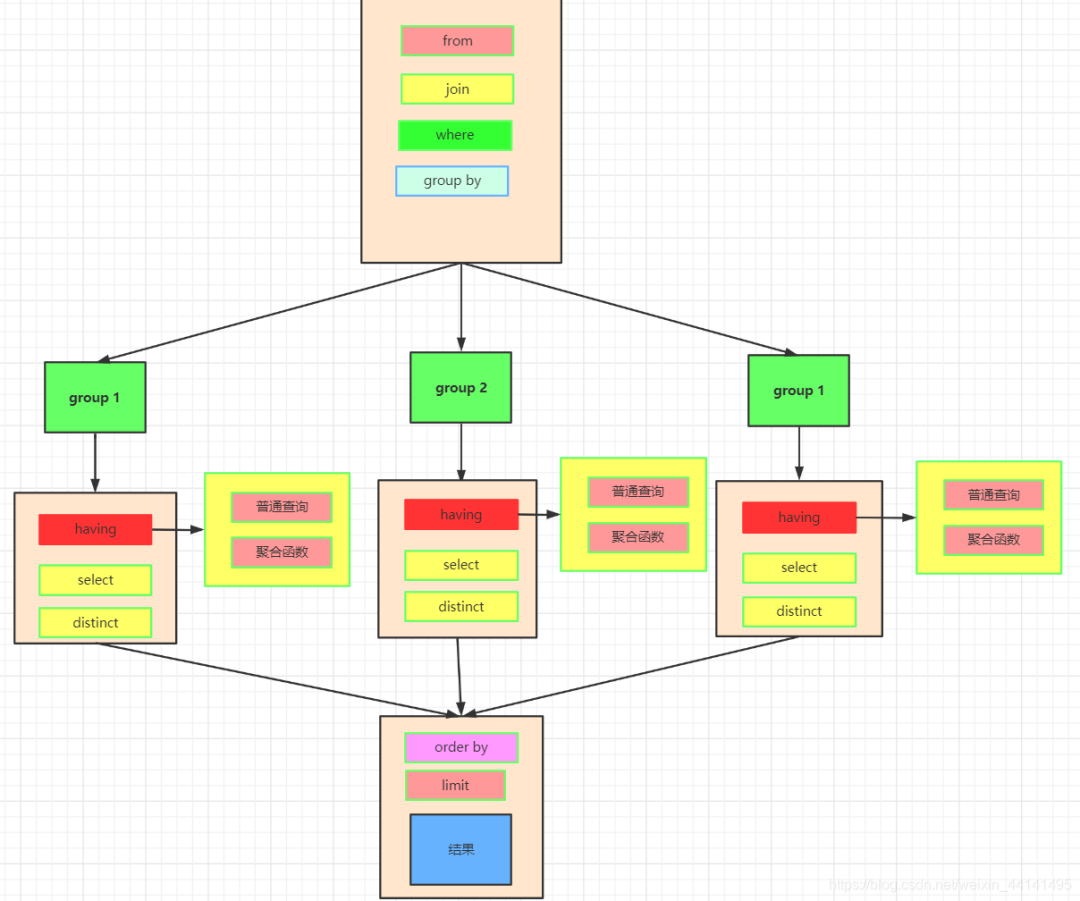

- 如果 L1 未命中,则查询 L2 Redis 缓存。